Guo Y. and Wei Z. Graph neural networks with learnable and optimal polynomial bases. ICML, 2023.

概

自动学多项式基的谱图神经网络.

符号说明

- \(V\), node set, \(|V| = N\);

- \(E\), edge set;

- \(\hat{P}\), normalized adjacency matrix;

- \(\hat{L} = I - \hat{P}\), normalized Laplacian matrix;

- \(X \in \mathbb{R}^{N \times d}\), node features.

Motivation

-

一般的普通神经网络可以表述为如下的形式:

\[Z = \sum_{k=0}^K \alpha_k g_k(\hat{P}) X, \]其中 \(g_k(\hat{P})\) 通常是多项式基.

-

特别的, \(\{g_k\}\) 通常关于非负的权重函数 \(w(\cdot)\) 正交, 即

\[ \langle g_i, g_j \rangle = \int_{a}^b g_i(x) g_j(x) w(x) \text{d}x = 0, \quad \text{if } i \not = j. \] -

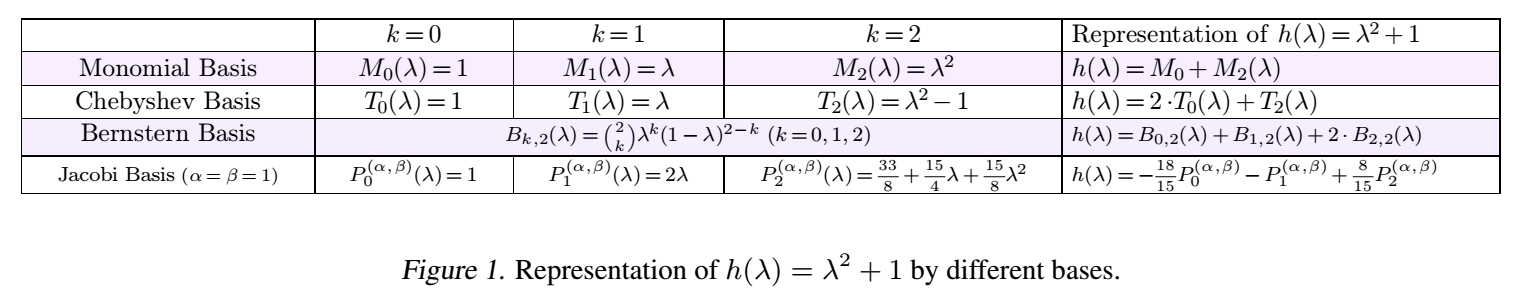

一些常见的多项式基如下所示:

-

大部分叫的上名字的多项式基都被考虑过了, 当然因为这些叫的上名字的多项式基或多或少都有一些比较好的性质, 本文的一个想法是, 不能够自己学一个多项式基呢?

FavardGNN

-

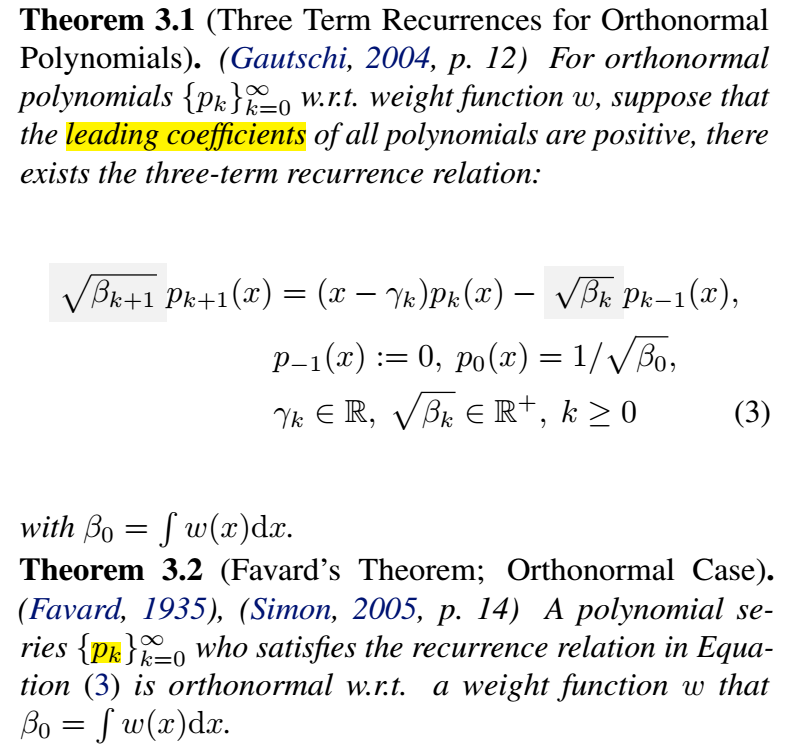

首先, 有如下的两个定理:

-

即, 对于任意的正交多项式基, 我们能够构造出 three-term recurrence 的迭代公式, 反之, 一旦我们构造出了这样的迭代公式, 也就确定了一个(正交)多项式基.

-

其实, 如果对 Chebyshev, Jacobi 不陌生的同学已经发现, 这些多项式基的定义, 本身就是 three-term recurrence 形式的.

-

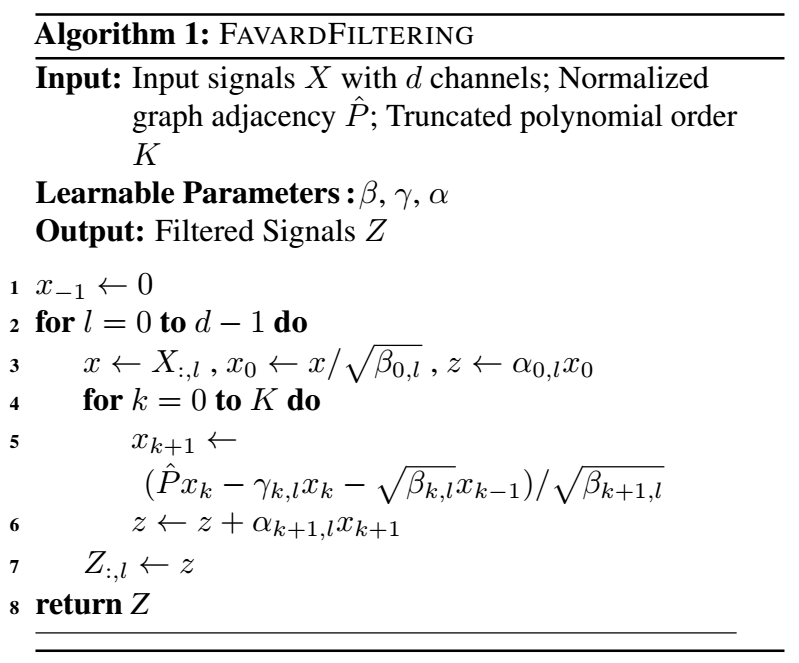

总而言之, 只要我们将 \(\{\sqrt{\beta_k}\}, \{\gamma_k\}\) 视作可学习的参数, 则我们就可以自动地学习一个比较好的多项式基. 当然了 \(\sqrt{\beta_k}\) 所对应的可学习参数需要保证是非负的.

-

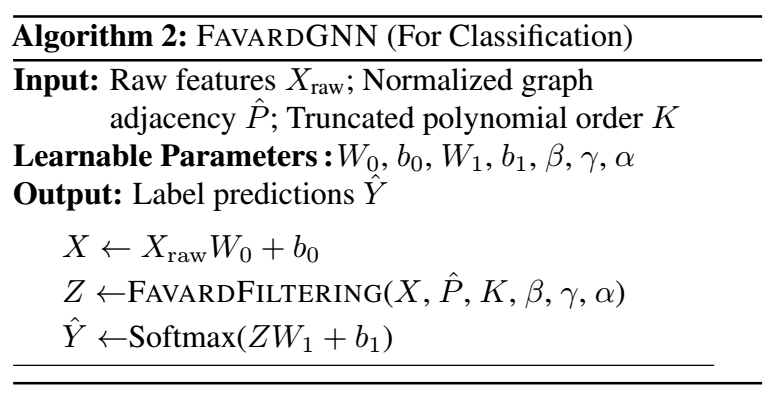

于是, 由此导出的 FavardGNN 便可表示为:

注: 作者还讨论了一种加了额外限制的多项式基, 有兴趣的可以回看原文.

代码

[official]

- Polynomial Learnable Networks Optimal Neuralpolynomial learnable networks optimal learning networks neural hello graph condensation networks neural understanding plasticity networks neural networks neural bigdataaiml-ibm-a introduction decoupling networks neural depth pre-train learning networks neural convolutional networks neural cnn powerful networks spectral neural sequence learning networks neural