Spatiotemporal Remote Sensing Image Fusion Using Multiscale Two-Stream Convolutional Neural Networks

abstract

地表反射率图像的渐变和突变是现有STF方法的主要挑战。(Gradual and abrupt changes in land surface reflectance images are the main challenges in existing STF methods.)

提出了多尺度双流卷积神经网络,在特征学习中从一张粗空间分辨率图像和其他日期的两对粗、细空间分辨率(FR)图像中捕捉不同大小的物体。(Multiscale two-stream convolutional neural networks are proposed to capture different sizes of objects in feature learning from a coarse spatial resolution image and two pairs of coarse and fine spatial resolution (FR) images at other dates.)

同时,探讨了时间依赖性和时间一致性作为STFMCNN的补充信息.( Meanwhile, temporal dependence and temporal consistency are explored as complementary information for STFMCNN.)

此外,还开发了一种局部融合方法,通过结合来自每个数据流的两个预测图像来描述局部变化的特征。(Moreover, a local fusion method is developed to characterize local variation by combining two predicted images derived from each stream.)

introduction

目前传统STF有两个主要挑战:

- 首先,植被物候或生长以及太阳高度的季节性变化所引起的逐渐变化可能导致光谱响应中终端成员的变化。

- 其次,土地覆盖类别转换引起的突然变化导致现有FR图像中没有类似的精细像素。

对于渐变,大多数现有的STF方法可以处理,并成功预测与植被候学和土壤水分渐变相关的像素.

对于突然的变化,这是STF方法最困难的情况,因为突然的变化只能在预测日期的CR图像中捕捉到,而在其他日期的可用FR图像中无法捕捉到。

Zhu等人[8]提出了FSDAF方法,对预测日期的CR图像进行降尺度处理,并借助其他日期的一对CR和FR图像重新分配突变像素的残差。FSDAF能够估计预测日期的CR图像中明显的突变,但很难重建CR图像中的微小突变。

一对案例的STF方法(如FSDAF)只使用其他日期的一对CR-FR图像和预测日期的CR图像作为输入来估计预测日期的FR图像,导致难以有效捕捉突然的变化.

预测日期的CR图像和两对CR-FR图像,一对在预测日期之前获得,另一对在预测日期之后获得(也被称为两对案例STF),已经被采用,从FR和CR图像中提取突变互补信息,以提高突变的重建性能,估计预测日期的FR图像。

与其他四组方法相比,基于学习的STF方法不考虑渐变和突变,而是使用一个统一的框架来建立CR和FR原始或差异图像之间的复杂关系。

现有基于SR的STF方法的缺陷:

- SRCNN只有三个卷积层,相对于一些先进的卷积神经网络,它不能充分利用深度特征。

- 有效的多尺度特征很少被提取,以捕捉不同尺寸的物体来改善STF,因为流行的多尺度特征提取模块,阿特拉斯空间金字塔池(ASPP),已经在各种应用中证明了其效率和效果。

- 虽然在[22]、[23]和[31]中采用了简单的不同滤波大小的卷积层,但由于大量的重复计算,它们的效率通常较低[37]、[39]。

- 此外,从每对CR图像得出的全局融合参数很难捕捉到局部的变化,当两对CR-FR图像被用来增强基于学习的预测时,它们可能进一步导致对未知FR图像的不准确预测[22]。

解决方法:

因此,本文提出了一种新的时空遥感图像融合方法,使用多尺度双流卷积神经网络(STFMCNNs)来处理两对参考图像的情况。STFMCNN比现有的基于SRCNN的STF方法提出了一个更深的模型,并采用ASPP来提取每对CR-FR图像的多尺度特征。

受[22]的启发,STFMCNN利用了输入FR图像的时间依赖性(TD)和时间一致性(TC),它们被用作受限的补充信息,以充分纳入两对CR-FR图像。开发了一种局部融合方法来融合从每对CR-FR图像得到的两幅预测的FR图像。

METHODOLOGY

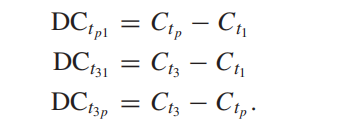

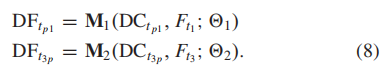

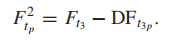

\(C_{t_{1}}\),\(C_{t_{p}}\),\(C_{t_{3}}\)分别代表三个时刻的粗分辨率图片,他们之间的差值为:

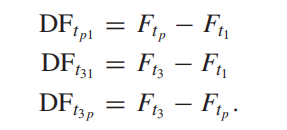

\(F_{t_{1}}\),\(F_{t_{p}}\),\(F_{t_{3}}\)分别代表三个时刻的细分辨率图片,他们之间的差值为:

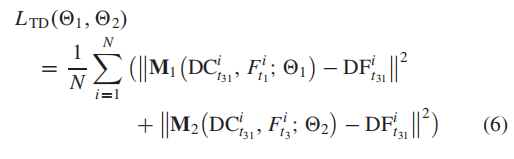

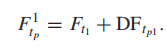

故\(F_{t_{p}} =F_{t_{1}}+DF_{t_{p1}}\)或\(F_{t_{p}} =F_{t_{3}}-DF_{t_{3p}}\). 预测两个FR差分图像的一个直接方法是对每对CR-FR差分图像之间的复杂关系进行建模。然而,这种方式由于其不确定的涣散反问题,往往不太有效[21], [22]。

建立复杂关系模型的另一种方法是将CR和FR差分图像与两个已知的FR图像Ft1和Ft3结合起来,这可以作为一种FR补充信息,在特定的空间细节中用于减少不确定的反问题[22].

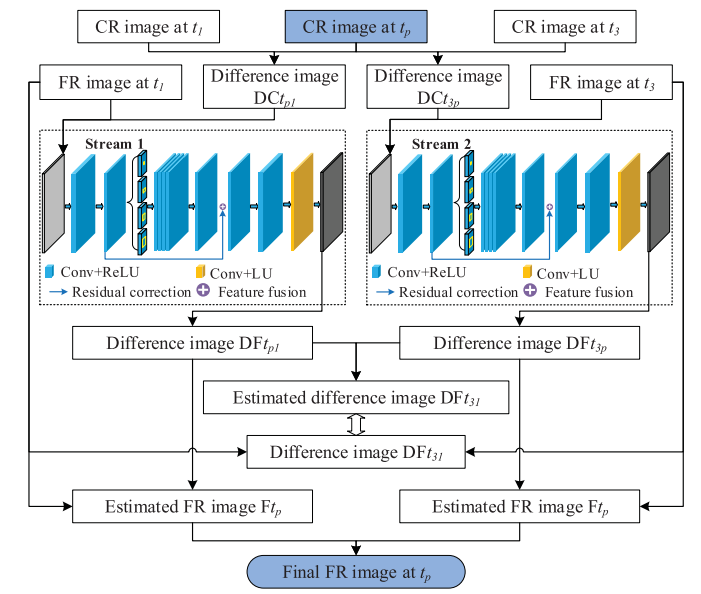

因此,STFMCNN遵循第二种方式,从两对CR-FR图像和预测日期的CR图像中预测两幅FR差异图像\(DF_{t_{p1}}\)和\(DF_{t_{3p}}\)。最后,两个预测的FR差异图像与两个已知的FR图像\(F_{t1}\)和\(F_{t3}\)相结合,得到预测日期tp的未知FR图像。如图1所示.

STFMCNN Architecture

省略网络结构;

图一左边左边和右边两个分支,分别利用三张图像预测FR光谱变化量。但由于确实\(F_{p}\),这是自监督,效果肯定不行. 但根据公式\(DF_{t31} = DF_{tp1}+DF_{t3P}\),\(DF_{t31}\)已知,可以给两个变化量适当的监督.

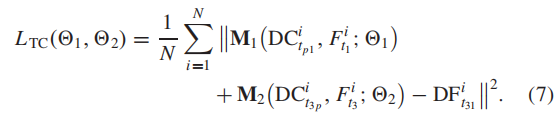

如果预测日期tp的FR图像是由每对CR-FR图像独立估计的,那么在日期tp的两个预测的FR图像之间的差异可能是明显的,它们进一步阻碍了对未知FR图像的预测。通过上面这种方式保持了时间一致性(TC).

STFMCNN Training

然而,两个已知的FR图像F1和F3未能被充分利用来提高空间结构相似性的学习能力。

TD信息可以从CR差分图像\(DC_{t31}\)到FR差分图像\(DF_{t31}\)中探索,为此要加入FR图像\(F_{t1}\)或\(F_{t3}\)[22]。

在[22]中,TD被定义为差异图像与它们相邻的原始图像的相关性。

换句话说,差异图像的时间变化模式往往与原始图像有关,因此,TD使用FR图像来模拟其与预测的FR差异图像的时间关系,提高从CR差异图像到FR差异图像的映射能力。

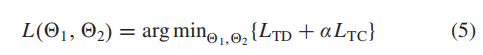

因此,损失的目标被设计为使TC和TD的综合信息与地面实况数据之间的均方误差(MSE)最小,它被表述为:

STFMCNN Prediction

预测两个差分图像:

两个方向的预测结果

STFMCNN Fusion

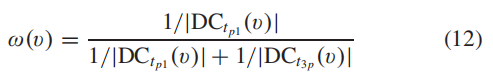

以前的工作[22]使用了一个全局融合权重,由每个预测的FR图像的CR图像的绝对平均变化来计算,这很难抓住每个CR像素的局部变化。

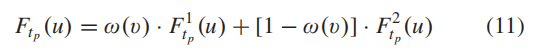

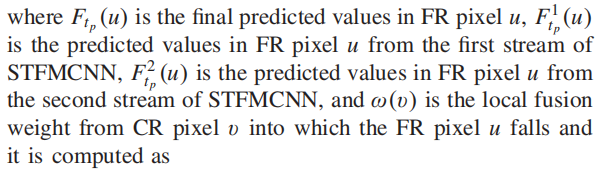

因此,为每个CR像素提出了一种局部融合方法,以充分利用STFMCNN中每个流的预测FR图像\(F_{tp}^{1}\)和\(F_{tp}^{2}\)的优势。

本地融合方法对每个CR像素采用滑动窗口来计算局部融合权重。最终的FR图像\(F_{tp}\)由所提出的局部加权方法融合为:

EXPERIMENTS

第一个实验旨在将Landsat-8图像作为CR图像和Sentinel-2图像作为FR图像进行融合,而第二个实验旨在将MODIS图像作为CR图像和Landsat-5图像作为FR图像进行融合。

第一个实验有明显的渐变和少数突变,而第二个实验有明显的突变和少数渐变。

第一个实验和第二个实验中FR和CR图像的空间分辨率比分别为3和16。

- Spatiotemporal Convolutional Multiscale Two-Stream Networksspatiotemporal convolutional multiscale two-stream classification convolutional imagenet networks convolutional segmentation biomedical networks convolutional stochastic reduction networks convolutional segmentation networks semantic recommendation convolutional networks hamming convolutional distilling knowledge networks skeleton-based convolutional recognition networks convolutional networks neural cnn fully-convolutional convolutional networks tracking