distillation knowledge stronger teacher

[论文阅读] Anomaly detection via reverse distillation from one-class embedding

Anomaly detection via reverse distillation from one-class embedding Introduction 在知识蒸馏(KD)中,知识是在教师-学生(T-S)对中传递的。在无监督异常检测的背景下,由于学生在训练过程中只接触到正常样本,所以当查询是 ......

Teacher Forcing

Teacher forcing 是一种在序列任务重的技术。它最初提出的动机是使得RNN的训练得以并行,加快模型训练。 简单来说Teacher forcing就是将数据集中的标签作为模型输入。 首先,以RNN为例,介绍Teacher forcing的技术细节。下图为RNN展开的计算图。 如图所示,Te ......

DE-RRD: A Knowledge Distillation Framework for Recommender System

目录概DE-RRDDistillation Experts (DE)Relaxed Ranking Distillation (RRD)代码 Kang S., Hwang J., Kweon W. and Yu H. DE-RRD: A knowledge distillation framewor ......

Topology Distillation for Recommender System

目录概Topology DistillationFull Topology Distillation (FTD)Hierarchical Topology Distillation (HTD)代码 Kang S., Hwang J., Kweon W. and Yu H. Topology dist ......

Collaborative Distillation for Top-N Recommendation

目录概符号说明Collaborative distillation (CD) Lee J., Choi M., Lee J. and Shim H. Collaborative distillation for top-N recommendation. ICDM, 2019. 概 Ranking- ......

Relational Knowledge Distillation

目录概符号说明RKD代码 Park W., Kim D., Lu Y. and Cho M. Relational knowledge distillation. CVPR, 2019. 概 符号说明 \(f_T, f_S\), teacher and student model; \(\mathc ......

Ranking Distillation: Learning Compact Ranking Models With High Performance for Recommender System

目录概符号说明Ranking Distillation代码 Tang J. and Wang K. Ranking Distillation: Learning compact ranking models with high performance for recommender system. ......

ACL2022 paper1 CAKE: A Scalable Commonsense-Aware Framework for Multi-View Knowledge Graph Completion

CAKE:用于多视域知识图谱补全的可扩展常识感知框架 ACL2022 Abstract 知识图谱存储大规模事实三元组,然而不可避免的是图谱仍然具有不完整性。(问题)以往的只是图谱补全模型仅仅依赖于事实域数据进行实体之间缺失关系的预测,忽略了宝贵的常识知识。以往的知识图嵌入技术存在无效负抽样和事实域链 ......

知识图谱Knowledge Spectrum

基于图的数据结构,由节点(Point)和边(Edge)组成。在知识图谱里,每个节点表示现实世界中存在的“实体”,每条边为实体与实体之间的“关系”。知识图谱是关系的最有效的表示方式。通俗地讲,知识图谱就是把所有不同种类的信息(Heterogeneous Information)连接在一起而得到的一个关 ......

knowledge Spectrum miscellaneous

WordNet WordNet is a dataset that describes the associative characteristics between English vocabulary words and also serves as a database. This datab ......

Time-aware Path Reasoning on Knowledge Graph for Recommendation

[TOC] > [Zhao Y., Wang X., Chen J., Wang Y., Tang W., He X. and Xie H. Time-aware path reasoning on knowledge graph for recommendation. TOIS, 2022.](h ......

论文解读(TAMEPT)《A Two-Stage Framework with Self-Supervised Distillation For Cross-Domain Text Classification》

论文信息 论文标题:A Two-Stage Framework with Self-Supervised Distillation For Cross-Domain Text Classification论文作者:Yunlong Feng, Bohan Li, Libo Qin, Xiao Xu, ......

知识图谱(Knowledge Graph)- Neo4j 5.10.0 使用 - Python 操作

数据基于: [知识图谱(Knowledge Graph)- Neo4j 5.10.0 使用 - CQL - 太极拳传承谱系表](https://www.cnblogs.com/vipsoft/p/17631347.html) 这是一个非常简单的web应用程序,它使用我们的Movie图形数据集来提供列 ......

Mixture-of-Domain-Adapters: Decoupling and Injecting Domain Knowledge to Pre-trained Language Mod...

### 1. Abstract 经过预训练的语言模型(PLM)表现出在通用领域理解文本的出色能力,同时在特定领域中表现不佳。**尽管在大型领域特定语料库上继续预训练是有效的,但调整领域上的所有参数是昂贵的**。在本文中,我们研究了是否可以通过只调整几个参数来有效地调整PLM。具体来说,我们将Tran ......

知识图谱(Knowledge Graph)- Neo4j 5.10.0 使用 - Java SpringBoot 操作 Neo4j

上一篇使用了 CQL 实现了太极拳传承谱,这次使用JAVA SpringBoot 实现,只演示获取信息,源码连接在文章最后 三要素 在知识图谱中,通过三元组 集合的形式来描述事物之间的关系: - 实体:又叫作本体,指客观存在并可相互区别的事物,可以是具体的人、事、物,也可以是抽象的概念或联系,实体是 ......

论文解读(BSFDA)《Black-box Source-free Domain Adaptation via Two-stage Knowledge Distillation》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Black-box Source-free Domain Adaptation via Two-stage Knowledge Distillation论文作者:Shuai Wang, Daoan Zhan ......

论文解读(KDSSDA)《Knowledge distillation for semi-supervised domain adaptation》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Knowledge distillation for semi-supervised domain adaptation论文作者:Mauricio Orbes-Arteaga, Jorge Cardoso论 ......

论文解读(KD-UDA)《Joint Progressive Knowledge Distillation and Unsupervised Domain Adaptation》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Joint Progressive Knowledge Distillation and Unsupervised Domain Adaptation论文作者:Yanping Fu, Yun Liu论文来源 ......

GNN学习 Knowledge Graph Embedding(更新中)

# GNN学习 Knowledge Graph Embedding 前面提到的方法都是只有一种边的类型,接下来要扩展到有向,多种边的类型的图上,即异质图(heterogeneous graph) 异质图有这样的几种类型: + Relational GCNs + Knowledge Graphs + ......

知识图谱(Knowledge Graph)- Neo4j 5.10.0 使用 - CQL

删除数据库中以往的图 ``` MATCH (n) DETACH DELETE n ``` ### 创建节点 CREATE命令语法 > Neo4j CQL“CREATE”命令用于创建没有属性的节点。 它只是创建一个没有任何数据的节点。 ``` CREATE ( : { : ........ : } ) ......

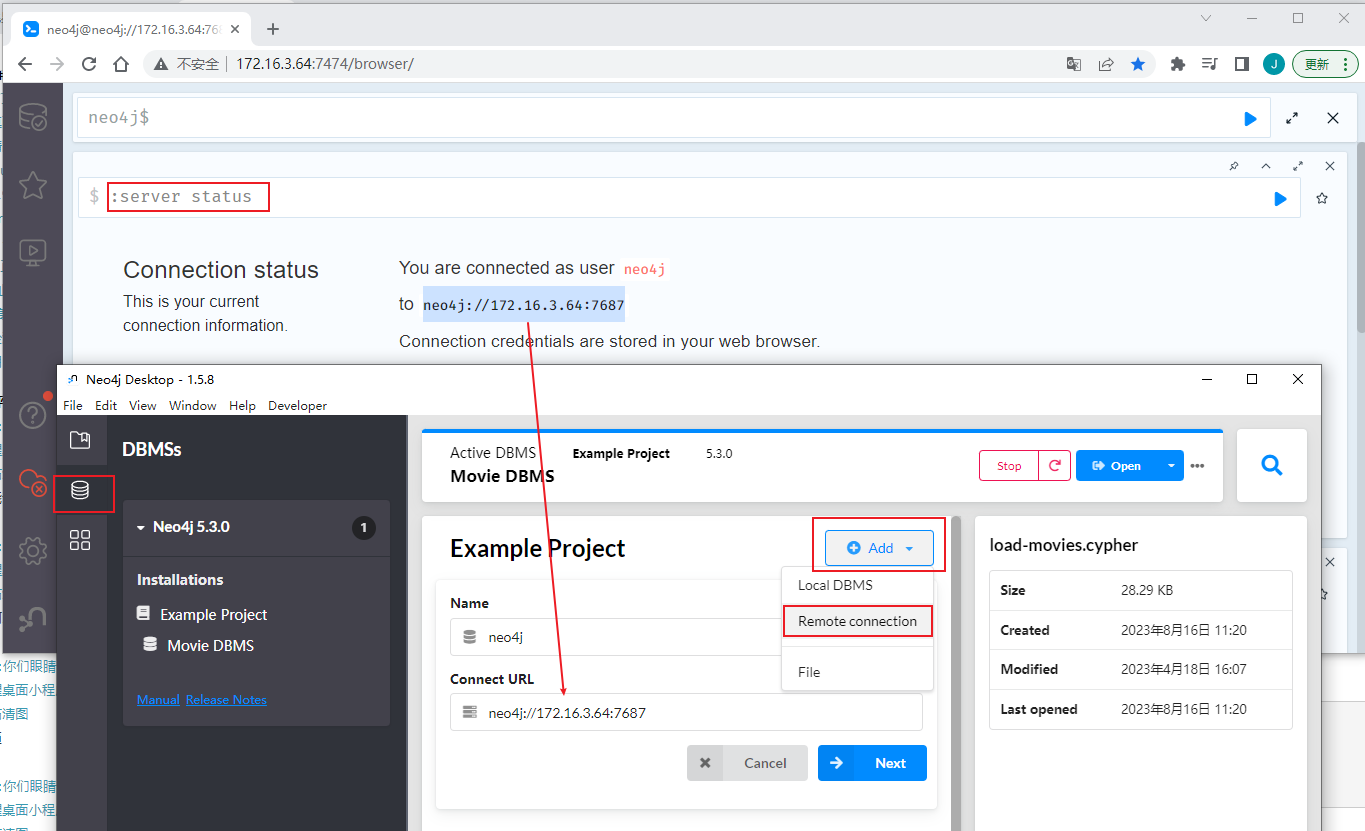

知识图谱(Knowledge Graph)- Neo4j 5.10.0 Desktop & GraphXR 连接自建数据库

``` #输入查看数据库连接 neo4j$ :server status ```  添加 远程连接,输入连接地址 ! ......

知识图谱(Knowledge Graph)- Neo4j 5.10.0 Desktop & GraphXR

下载地址:https://neo4j.com/download/ ## 安装  下载时会产生激活码(保存下来) ......

知识图谱(Knowledge Graph)- Neo4j 5.10.0 Docker 安装

### 拉镜像 ```bash [root@localhost ~]# cat /etc/docker/daemon.json { "registry-mirrors": ["https://XXX.mirror.aliyuncs.com"] # 阿里镜像源 } # 拉取镜像 [root@local ......

知识图谱(Knowledge Graph)- Neo4j 5.10.0 CentOS 安装

### 系统需求 版本 JDK CPU 内存 硬盘 Neo4j 5.x 17 Intel x86-x64 Core i3 minimum,Core i7 recommended. AMD x86-x64, Mac ARM. 最低 2GB,推荐 16GB + 10G + Neo4j 5.x 11 Ne ......

知识图谱(Knowledge Graph)根本概念

[TOC] 2012年5月17日,Google 正式提出了知识图谱(Knowledge Graph)的概念,其初衷是为了优化搜索引擎返回的结果,增强用户搜索质量及体验。 假设我们想知道 “王健林的儿子” 是谁,百度或谷歌一下,搜索引擎会准确返回王思聪的信息,说明搜索引擎理解了用户的意图,知道我们要找 ......

论文解读(AAD)《Knowledge distillation for BERT unsupervised domain adaptation》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Knowledge distillation for BERT unsupervised domain adaptation论文作者:Minho Ryu、Geonseok Lee、Kichun Lee论文来 ......

论文解读(Moka‑ADA)《Moka‑ADA: adversarial domain adaptation with model‑oriented knowledge adaptation for cross‑domain sentiment analysis》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Moka‑ADA: adversarial domain adaptation with model‑oriented knowledge adaptation for cross‑domain senti ......

论文解读()《Cluster Alignment with a Teacher for Unsupervised Domain Adaptation》

Note:[ wechat:Y466551 | 付费咨询,非诚勿扰 ] 论文信息 论文标题:Cluster Alignment with a Teacher for Unsupervised Domain Adaptation论文作者:Zhijie Deng, Yucen Luo, Jun Zhu论 ......

Knowledge-QA-LLM: 基于本地知识库+LLM的问答系统

## ⚠️注意:后续更新,请移步[README](https://github.com/RapidAI/Knowledge-QA-LLM) ## Knowledge QA LLM =3.8, - 基于本地知识库+LLM的问答系统。该项目的思路是由[langchain-ChatGLM](https:/ ......