embedding torch nn

Torch计算指标-ACC、Recall、Precision、NDCG、HR、ARHR

Calculating Binary Classification Metrics (Accuracy, Recall, Precision, F1, DCG, NDCG, HR, ARHR) for Batched Data using Torch - Input: pred -> [B, N], ......

nn.Sequential 、 nn.ModuleList 、 nn.ModuleDict区别

1、nn.Sequential 、 nn.ModuleList 、 nn.ModuleDict 类都继承自 Module 类。 2、各自用法 net = nn.Sequential(nn.Linear(128, 256), nn.ReLU())net = nn.ModuleList([nn.Lin ......

torch基础操作汇总(常更新)

已知一个torch tensor[2,4,5,6],要取其中对应的索引位置(2,3),怎么操作 你可以使用 PyTorch 的索引操作来从给定的张量中提取特定索引位置的元素。在你提供的示例中,张量是 [2, 4, 5, 6],你希望提取的索引位置是 (2, 3)。以下是如何进行操作: import ......

GNN学习 Knowledge Graph Embedding(更新中)

# GNN学习 Knowledge Graph Embedding 前面提到的方法都是只有一种边的类型,接下来要扩展到有向,多种边的类型的图上,即异质图(heterogeneous graph) 异质图有这样的几种类型: + Relational GCNs + Knowledge Graphs + ......

torch tensor,boxes[:][:2] -= boxes[:][:2]/2 报错

因为在 PyTorch 中进行切片操作时,不支持使用 `[:][:2]` 的方式进行多次切片。正确的方式是将两次切片操作合并成一次。在你的代码中,你可能想要对所有的 boxes 进行操作,对每个 box 的前两个元素进行减法操作。 以下是正确的代码示例: ```python import torch ......

聊聊Embedding(嵌入向量)

摘要自《深入浅出Embedding》一问。具体详细内容请移步该书。 ## 概述 简单来说,嵌入是用向量表示一个物体,这个物体可以是一个单词、一条语句、一个序列、一件商品、一个动作、一本书、一部电影等,可以说嵌入(Embedding)涉及机器学习、深度学习的绝大部分对象。这些对象是机器学习和深度学习中 ......

Pytorch中使用Embedding报错'IndexError'的解决方法

# 简介 Pytorch中`nn.Embedding`为针对词向量的层,其用来实现词与词向量的映射。其调用形式如下 ```python nn.Embedding( num_embeddings: int, embedding_dim: int, padding_idx: int | None = N ......

模型超参数基本都没改,测试时加载模型报模型结构不匹配,设置模糊加载模型即:model.load_state_dict(torch.load(model_path), strict=Fasle),但效果出奇的差

# 原因 跑模型的时候,用的是多卡加载torch.nn.DataParallel(self.model),测试是用的单卡模糊加载保存的模型权重,很多模型参数都没有加载成功,自然会导致测试效果很差。 # 解决方法 ` # 如果你想要用nn.DataParallel来加载模型 state_dict = ......

torch.cat()

要将一个大小为(2, 2)的PyTorch张量和一个大小为(1, 2)的张量拼接在一起,以形成一个新的大小为(3, 2)的张量,你可以使用PyTorch库中的torch.cat()函数。以下是一个示例代码: import torch # 假设你有一个大小为(2, 2)的张量 tensor1 和一个大 ......

Query on Embedded/Nested Documents

This page provides examples of query operations on embedded/nested documents using the db.collection.find() method in mongosh. The examples on this pa ......

大连人工智能计算平台——华为昇腾AI平台——高性能计算HPC的pytorch环境报错——torch.cuda.is_available()显示false——NVIDIA显卡驱动版本过低导致pytorch无法使用cuda

在使用这个HPC平台的时候发现了这么一个问题,那就是编译好的pytorch-cuda和anaconda官方安装的pytorch-cuda均不能调用cuda计算,这个现象十分的诡异,经过长时间的调查发现了问题所在——NVIDIA驱动版本过低。 给出该HPC的显卡驱动版本: ......

【d2l】【常见函数】【20】 torch.bmm( )

**局部矩阵乘法** 参考:https://pytorch.org/docs/stable/generated/torch.bmm.html , torch.unsqueeze( )

## torch.squeeze() **压缩大小为1的维度** 参考:https://pytorch.org/docs/stable/generated/torch.squeeze.html  )

**返回一个指定size的张量,元素是0~1之间的随机数** 参考: https://pytorch.org/docs/stable/generated/torch.rand.html

参考:https://pytorch.org/docs/stable/generated/torch.repeat_interleave.html

torch.all() 其中的所有项都为True,返回True,反之,返回False >>> import torch >>> a = torch.tensor([[1, 2], [3, 4]]) >>> b = torch.tensor([[1, 2], [3, 4]]) >>> a OUT: t ......

使用nn.Conv2d()和nn.MaxPool2d()调整输出的技巧

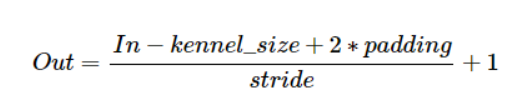

前提是没有使用dilation,牢记以下公式:  1.如果想保持张量大小不变,则:kenel_size=3(奇数), ......

torch的flatten函数

python:flatten()参数详解 这篇博客主要写flatten()作用,及其参数的含义 flatten()是对多维数据的降维函数。 flatten(),默认缺省参数为0,也就是说flatten()和flatte(0)效果一样。 python里的flatten(dim)表示,从第dim个维度开 ......

【d2l】【常见函数】【15】 nn.init.xavier_uniform_

**Xavier是一种很好的参数初始化方法** ## 参考1:https://pytorch.org/docs/stable/nn.init.html

**只对输入的张量的最后一个维度做全连接** 参考:https://pytorch.org/docs/stable/generated/torch.nn.Linear.html ## 问题来源

**Repeats this tensor along the specified dimensions.** 参考:https://pytorch.org/docs/stable/generated/torch.Tensor.repeat.html

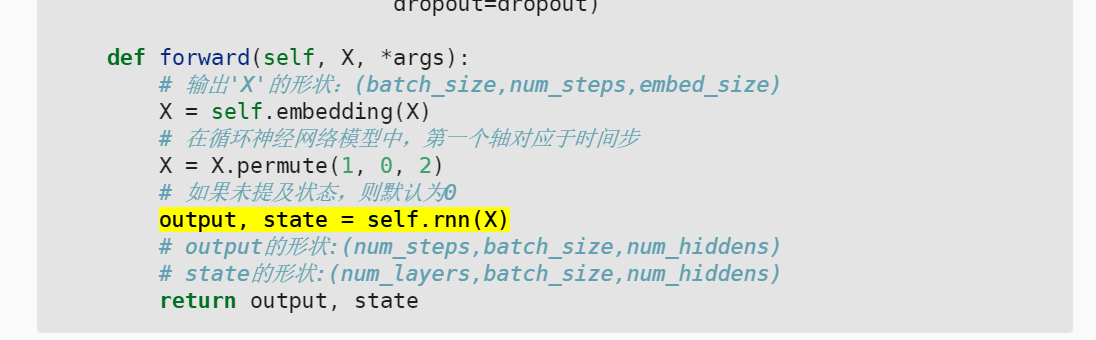

**门控循环神经网络的API** ## 问题来源 【动手学深度学习】【9.7 序列到序列学习】  这个output ......

【d2l】【常见函数】【9】 nn.Embedding()

**将输入的序列转换词向量** 转载:https://www.jianshu.com/p/63e7acc5e890 ,本帖仅用于学习,**请给原博主点赞** 参考:https://pytorch.org/docs/stable/generated/torch.nn.Embedding.html ## ......

nn.MaxPool2d()、transpose().contiguous()、view()说明

**1.nn.MaxPool2d()** 和nn.Conv2D()基本一样,但是stride默认值是kernel_size。 **2.transpose().contiguous()、view()** contiguous一般与transpose,permute,view搭配使用:使用transpo ......

nn.Conv2d()参数说明、输入输出

**1.参数说明**  2.输入输出参数计算

**指定读取张量的设备,如GPU,CPU** 参考:https://blog.csdn.net/shaopeng568/article/details/95205345  technique that converts text into numerical vectors. Embeddings capture s ......