Conv

Conv2Former: A Simple Transformer-Style ConvNet for Visual Recognition:使用大核卷积调制来简化注意力

Conv2Former: A Simple Transformer-Style ConvNet for Visual Recognition * Authors: [[Qibin Hou]], [[Cheng-Ze Lu]], [[Ming-Ming Cheng]], [[Jiashi Feng]] ......

Conv1D和Conv2D的区别

layer = layers.Conv1D(input_shape=(66, 5), filters=100, kernel_size=10, padding="same", activation="relu", strides=1) 上述例子为例,实际上和二维卷积是一样的,只不过卷积核的第二个维度 ......

<class 'torch.nn.modules.conv.Conv1d'> torch.nn.Conv1d

1、Conv1d 定义class torch.nn.Conv1d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True) 自然语言处理中一个句子序列,一维的,所以使用C ......

优雅地在Numpy实现Conv2D

何为优雅: - 编写优雅——算法符合直觉,容易理解 - 执行优雅——执行高效 本文将围绕这俩点逐步对Numpy下卷积算子的实现拨茧抽丝。在文章的开头先声明一下这篇文章数据格式规范。 - 输入 [N, Cin, H, W] - 卷积核 [Cin, Kx, Ky, Cout] - 输出 [N, Cout ......

使用nn.Conv2d()和nn.MaxPool2d()调整输出的技巧

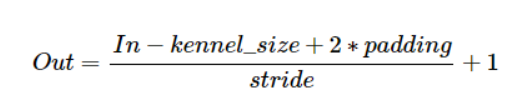

前提是没有使用dilation,牢记以下公式:  1.如果想保持张量大小不变,则:kenel_size=3(奇数), ......

nn.Conv2d()参数说明、输入输出

**1.参数说明**  2.输入输出参数计算 。这也可能是传统CNN虽然在ImageNet上跟Transformer差不多,但在下游任务上普遍不如Transfo ......