Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ]

论文信息

论文标题:UDALM: Unsupervised Domain Adaptation through Language Modeling

论文作者:Constantinos Karouzos, Georgios Paraskevopoulos, Alexandros Potamianos

论文来源:2021 aRxiv

论文地址:download

论文代码:download

视屏讲解:click

1 介绍

动机:探索了无监督域自适应(UDA)中针对下游任务的预训练语言模型的;

摘要:引入了 UDALM,使用分类和屏蔽语言模型损失,可以以鲁棒和样本效率的方式适应目标域分布;

贡献:

-

- 提出了 UDALM ,一个基于多任务学习的 简单、健壮的无监督域适应过程下游 Bert 模型;

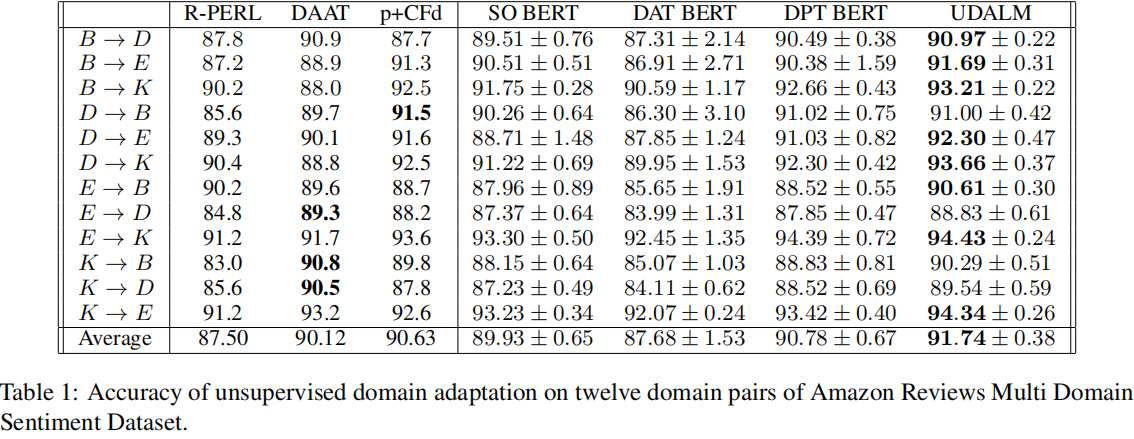

- 在 亚马逊评论基准数据集 分类为 SOTA;

- 基于理论概念和经验观察,探讨了距离与目标误差的关系,并总结了领域对抗训练的理论;

2 方法

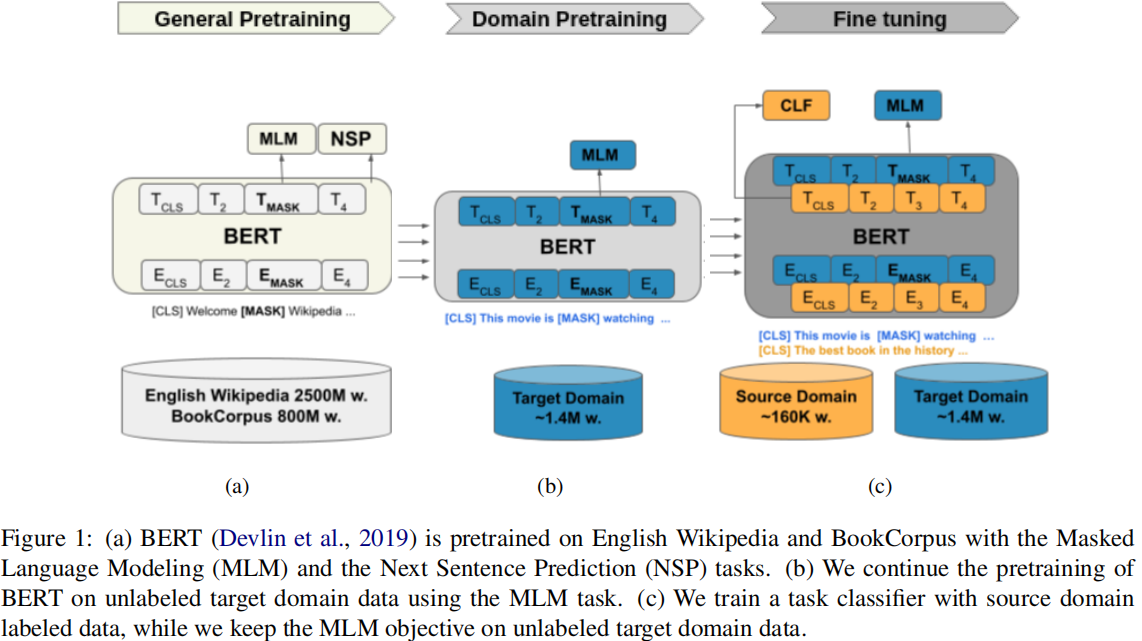

模型框架:

2.1 训练步骤

Step1:Fig.1a 在大规模数据集上进行 MLM 、NSP 预训练;

Step2:Fig.1b 使用上述预训练好的模型在 目标域内进行 MLM 训练;

Step3:在源域数据上进行监督训练,在目标域数据上进行 MLM 训练;

Step3 的损失函数:

$L(\mathbf{s}, \mathbf{t})=\lambda L_{C L F}(\mathbf{s})+(1-\lambda) L_{M L M}(\mathbf{t})$

其中:

$\lambda=\frac{n}{n+m}$

3 实验

结果

- UDALM Unsupervised Adaptation Language Modelingudalm unsupervised adaptation language class-imbalanced unsupervised adversarial adaptation tri-training unsupervised asymmetric adaptation unsupervised intra-class adaptation similarity mensa unsupervised adaptation ensemble domain discriminative unsupervised adaptation unsupervised adaptation training improve backpropagation unsupervised adaptation domain unsupervised discrepancy classifier adaptation unsupervised adaptation alignment cluster