spark3 spark 3.2

Spark架构体系

# Spark架构体系 StandAlone模式是spark自带的集群运行模式,不依赖其他的资源调度框架,部署起来简单。 StandAlone模式又分为client模式和cluster模式,本质区别是Driver运行在哪里,如果Driver运行在SparkSubmit进程中就是Client模式,如果 ......

Spark简介

# Spark Spark是一种快速、通用、可扩展的大数据分析引擎,2009年诞生于加州大学伯克利分校AMPLab,2010年开源,2013年6月成为Apache孵化项目,2014年2月成为Apache的顶级项目,2014年5月发布spark1.0,2016年7月发布spark2.0,2020年6月 ......

Spark基础

Spark是一种基于内存的快捷、通用、可扩展的大数据分析引擎 1. Spark模块 Spark Core: Spark核心模块,包含RDD、任务调度、内存管理、错误恢复、与存储系统交互等 Spark SQL:用于处理结构化数据的一个模块,提供了2个编程抽象:DataFrame DataSet,并且作 ......

如何在Databricks中使用Spark进行数据处理与分析

[toc] 1. 《如何在Databricks中使用Spark进行数据处理与分析》 随着大数据时代的到来,数据处理与分析变得越来越重要。在数据处理与分析过程中,数据的存储、处理、分析和展示是不可或缺的关键步骤。在数据处理与分析中,Spark是一个强大的开源计算框架,它可以处理大规模分布式数据集,并提 ......

3.2 鱼与熊掌可以兼得的深度学习-2022

# 1. 问题回顾 在上节的再谈宝可梦、数码宝贝分类问题上,我们提出了机器学习的分类原理.并提出了一个矛盾点:当可选参数过多,loss会变小,但理想和现实差距会很大;当可选参数比较少,loss会变大,但理想和现实差距会减小.现在我们需要一个Loss小,可选参数也少的模型. 所开源的类Hadoop MapReduce的通用并行框架,Spark,拥有Hadoop MapReduce所具有的优点;但 ......

基于Spark的大规模日志分析

摘要:本篇文章将从一个实际项目出发,分享如何使用 Spark 进行大规模日志分析,并通过代码演示加深读者的理解。 本文分享自华为云社区《【实战经验分享】基于Spark的大规模日志分析【上进小菜猪大数据系列】》,作者:上进小菜猪。 随着互联网的普及和应用范围的扩大,越来越多的应用场景需要对海量数据进行 ......

Flink 的 checkpoint 机制对比 spark 有什么不同和优势?

spark streaming 的 checkpoint 仅仅是针对 driver 的故障恢复做了数据和元数据的 checkpoint。 而 flink 的checkpoint 机制要复杂很多,它采用的是轻量级的分布式快照,实现了每个算子的快照,及流动中的数据的快照。 ......

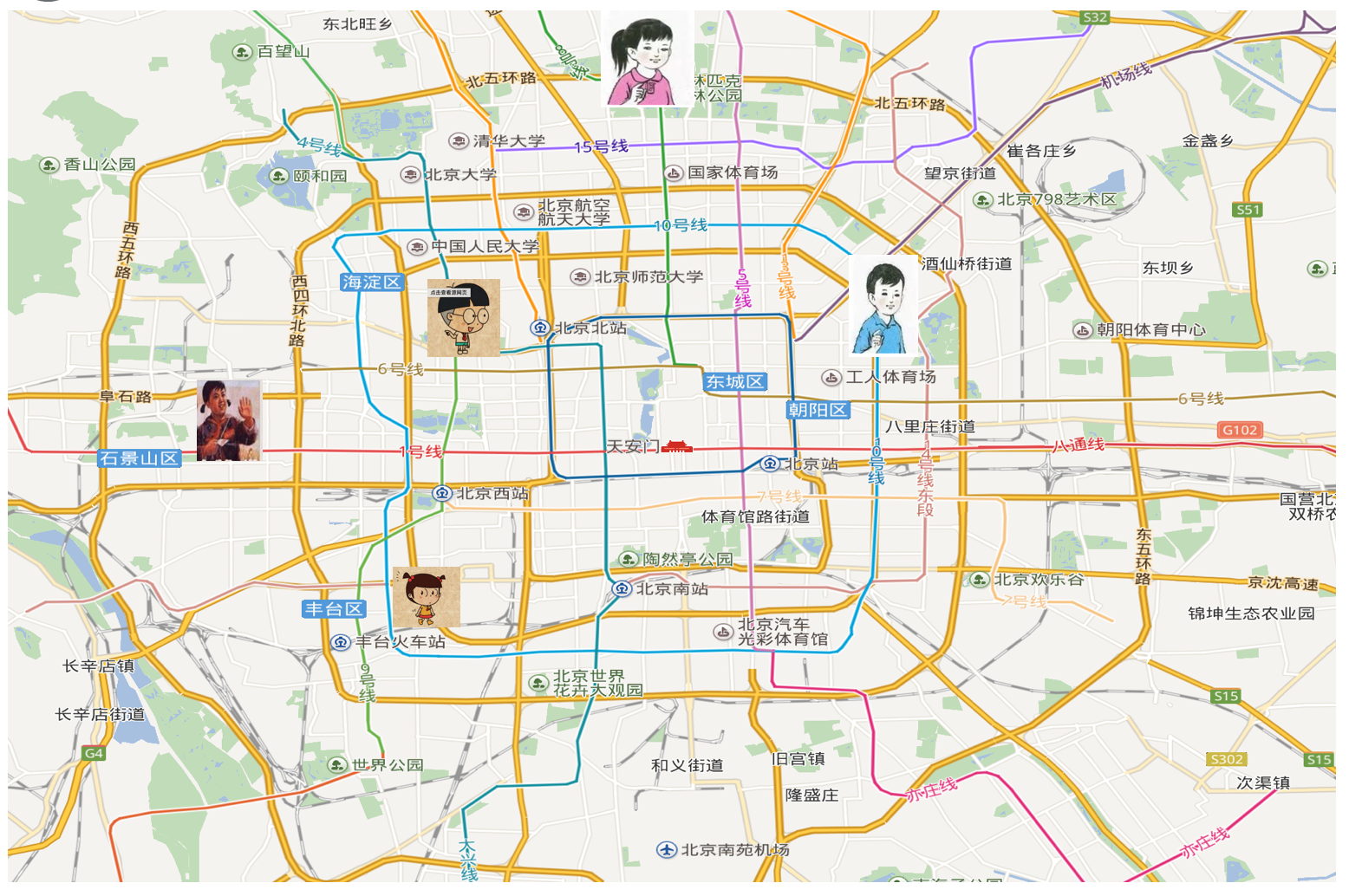

3.2 KNN算法(k-近邻算法)

# 1.什么是k-近邻算法 例如:  >**如果你不知道你现在在哪,你可以通过你和你的邻居的距离推算出你的 ......

Spark基础

# Spark基础 [toc] ## 1 Spark简介 ### 1.1 Spark介绍 - 什么是Spark 1. Apache Spark is an open source cluster computing system that aims to make data analytics fa ......

docker安装spark

curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose chmod +x ......

如何在window上使用spark

关于怎么使用spark在windos系统?下载anaconda下载spark怎么用呢?步骤1:打开anaconda prompt,激活步骤2:安装需要导入的东西步骤3:打开Jupyter Notebook,使用下面命令在一个py文件中步骤4:使用import导入成功使用 ......

spark调用HTTP请求并返回数据落地到数仓(or数据库)

POM xml复制代码 com.alibaba fastjson spark-sql依赖 --> org.apache.spark spark-sql_${scala.tools.version} org.apache.spark spark-hive_${scala.tools.version} ......

RDS 、HDFS、 mapreduce 、spark 、hive、 hbase 、zookeeper 、kafka 、flume、mysql 安装时之间配置文件是如何依赖的?

这些技术是大数据领域的常用组件,它们之间的配置文件依赖关系如下: RDS是一种关系型数据库,可以独立安装和使用,不需要依赖其他组件。 HDFS是Hadoop分布式文件系统,通常与MapReduce一起使用。在Hadoop集群中,HDFS需要配置core-site.xml和hdfs-site.xml两 ......

Java 新的生态,Solon v2.3.2 发布

Java 新的生态型应用开发框架:更快、更小、更简单。

启动快 5 ~ 10 倍;qps 高 2~ 3 倍;运行时内存节省 1/3 ~ 1/2;打包可以缩到 1/2 ~ 1/10;同时支持 jdk8, jdk11, jdk17, jdk20, graalvm native。 ......

Spark消费Kafka

0. 前言 之前先写了处理数据的spark,用文件读写测了一批数据,能跑出结果;今天调通了Kafka,拼在一起,没有半点输出,查了半天,发现是之前的处理部分出了问题,把一个不等号打成了等号,把数据全filter没了。很恐怖,我保证这段时间我没动过这段代码,但上次真的跑出东西了啊(尖叫 1. 配置流程 ......

Spark搭建

# Spark搭建 ## Local模式 > 主要用于本地开发测试 > > 本文档主要介绍如何在IDEA中配置Spark开发环境 * 打开IDEA,创建Maven项目 * 在IDEA设置中安装Scala插件 :指父RDD的每个分区只被子RDD的一个分区所使用,例如map、filter等这些算子 一个RDD,对它的父RDD只有简单的一对一的关系,也就是说,RDD的每个partition仅仅依赖于父RDD中的一个partition,父R ......

Spark之RDD相关

### 创建RDD RDD是Spark编程的核心,在进行Spark编程时,首要任务是创建一个初始的RDD,这样就相当于设置了Spark应用程序的输入源数据 然后在创建了初始的RDD之后,才可以通过Spark 提供的一些高阶函数,对这个RDD进行操作,来获取其它的RDD Spark提供三种创建RDD方 ......

Spark实战

### WordCount程序 这个需求就是类似于我们在学习MapReduce的时候写的案例 需求这样的:读取文件中的所有内容,计算每个单词出现的次数 注意:由于Spark支持Java、Scala这些语言,目前在企业中大部分公司都是使用Scala语言进行开发,个别公司会使用java进行开发,为了加深 ......

Spark详解

### 什么是Spark Spark是一个用于大规模数据处理的统一计算引擎 注意:Spark不仅仅可以做类似于MapReduce的离线数据计算,还可以做实时数据计算,并且它还可以实现类似于Hive的SQL计算,等等,所以说它是一个统一的计算引擎 既然说到了Spark,那就不得不提一下Spark里面最 ......

spark 常用参数和默认配置

##常用的Spark任务参数及其作用: 1. `spark.driver.memory`:设置driver进程使用的内存大小,默认为1g。 2. `spark.executor.memory`:设置每个executor进程使用的内存大小,默认为1g。 3. `spark.executor.cores ......

【博学谷学习记录】超强总结,用心分享 | spark知识点总结2

【博学谷IT技术支持】 #### Action动作算子 * reduce: 通过func函数聚集RDD中的所有元素,这个功能必须是可交换且可并联的 * collect: 在驱动程序中,以数组的形式返回数据集的所有元素 * count: 返回RDD的元素个数 * first: 返回RDD的第一个元素( ......

Windows 配置 Hadoop and Spark

一 JDK环境配置 由于项目用的JDK17,所以单独给Hadoop配了JDK11,建议直接配置JAVA_HOME环境变量为JDK11,因为后面Spark需要用到JAVA_HOME 下载JDK11 链接:https://www.oracle.com/java/technologies/javase/j ......

OpenHarmony 3.2 Release新特性解读之驱动HCS

OpenHarmony 3.2 Release版本驱动框架在原来的HDF架构基础上进行了细化,新增HCS宏式解析,使得系统ROM空间得到进一步的节省,增加参数调用效率;新增HCS可视化编辑器,提供hcsView扩展工具,极大的提高了HCS编译效率,降低了门槛,减少了错误率;新增HDF驱动代码模板自动... ......