Seq2seq

机器学习——序列到序列学习(seq2seq)

我们将使用两个循环神经网络的编码器和解码器, 并将其应用于序列到序列(sequence to sequence,seq2seq)类的学习任务。 编码器 由于这里使用的是门控循环单元, 所以在最后一个时间步的多层隐状态的形状是 (隐藏层的数量,批量大小,隐藏单元的数量)。 如果使用长短期记忆网络,st ......

聊聊RNN与seq2seq

seq2seq模型也称为Encoder-Decoder模型。顾名思义,这个模型有两个模块——Encoder(编码器)和Decoder(解码器)。编码器对输入数据进行编码,解码器对被编码的数据进行解码。此时编码器编码的信息浓缩了翻译所必需的信息,解码器基于这个浓缩的信息生成目标文本。 这里的数据一般指 ......

《动手学深度学习 Pytorch版》 9.7 序列到序列学习(seq2seq)

循环神经网络编码器使用长度可变的序列作为输入,将其编码到循环神经网络编码器固定形状的隐状态中。 为了连续生成输出序列的词元,独立的循环神经网络解码器是基于输入序列的编码信息和输出序列已经看见的或者生成的词元来预测下一个词元。 要点: “<eos>”表示序列结束词元,一旦输出序列生成此词元,模型就会停 ......

文本翻译,机器翻译序列(Seq2seq)

# Seq2seq # 进行机器翻译 import collections import math import os import torch from torch import nn from d2l import torch as d2l import matplotlib.pyplot as ......

seq2seq+attention的个人理解

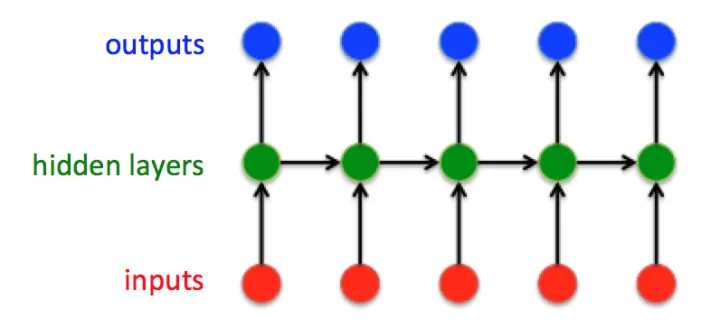

[toc] ## RNN 经典的RNN结构:  这是经典的RNN结构,输入向量是:  ## 一、seq2 ......