ICLR 2023 原文地址

1. Motivation

Chain-of-Thought(CoT)使Large Language Models(LLMs)在复杂的推理任务中取得了令人鼓舞的结果。

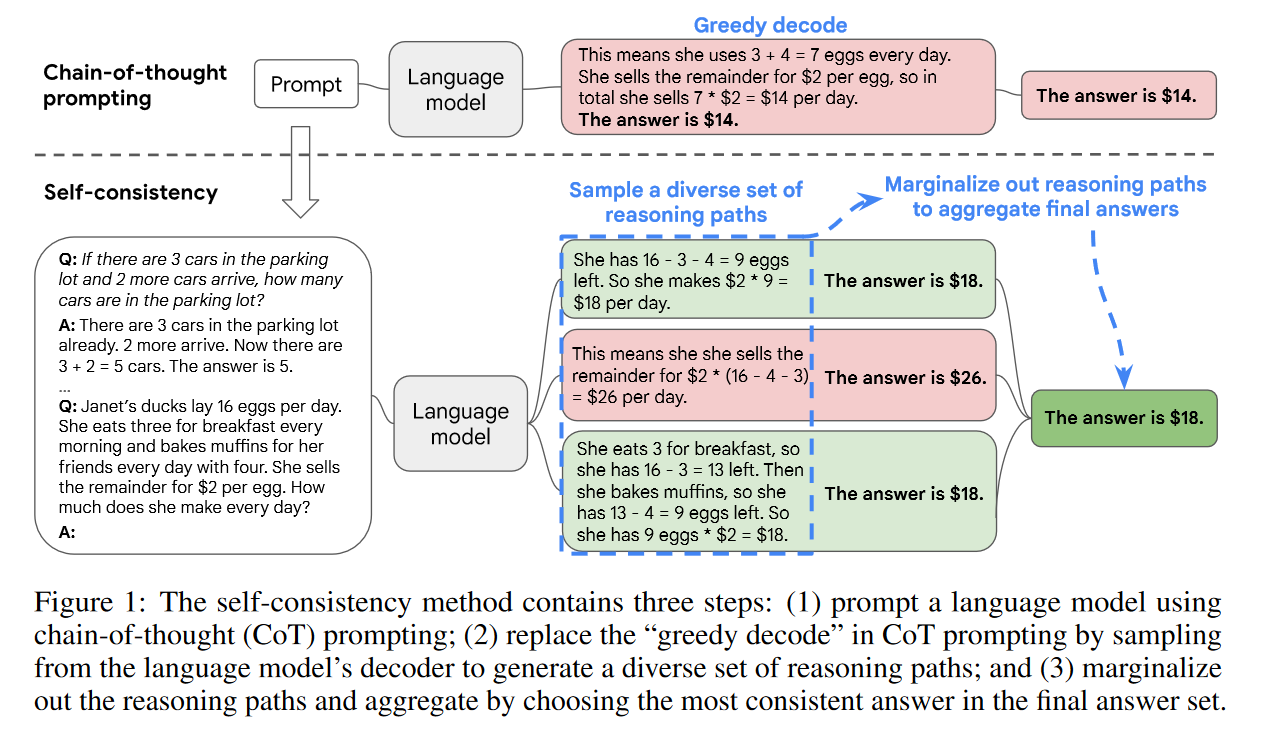

本文提出了一种新的解码策略——self-consistency,以取代贪婪解码。

self-consistency利用了一种直觉,即一个复杂的推理问题通常允许多种不同的思维方式推导出同一个正确答案。

2. Procedure

- 首先从语言模型的解码器中采样,生成一组不同的推理路径

- 每个推理路径可能导致不同的最终答案,通过边缘化(marginalizing out)这些推理路径来确定最优答案,即最一致的答案。

这种方法类似于人类的经验,如果多种不同的思维方式导致相同的答案,一个人更有信心最终的答案是正确的。

To be continue...

- Self-consistency consistency Reasoning Improves Languageself-consistency consistency reasoning improves self-consistency reasoning language towards models chain-of-thought prompting reasoning language synergizing reasoning language acting improves 英语学习 范文computer improves reasoning retrieval reasoning multi-hop answering reasoning bootstrapping self-taught reasoner