算子spark

Spark Yarn模式

独立部署(Standalone)模式由 Spark 自身提供计算资源,无需其他框架提供资源。这种方式降低了和其他第三方资源框架的耦合性,独立性非常强。但是Spark 主要是计算框架,而不是资源调度框架,所以本身提供的资源调度并不是它的强项,所以还是和其他专业的资源调度框架集成会更靠谱一些。 在国内工 ......

Spark 3.5.0 高可用部署

1.下载Spark 3.5.0 https://spark.apache.org/downloads.html 2.安装JDK Linux 安装Openjdk 3.安装Hadoop Hadoop-3.3.6分布式集群搭建步骤 4.安装Zookeeper ZooKeeper 3.9.1 集群模式安装 ......

Spark与RDD是什么

大数据框架可不是只有Hadoop哦,还有一个非常厉害的框架,它就是——Spark。 一:什么是Spark Apache Spark是一个快速通用的集群计算系统,是一种与Hadoop相似的开源集群计算环境,但是Spark在一些工作负载方面表现得更加优越。它提供了Java、Scala、Python和R的 ......

2023CANN训练营第2季————Ascend C算子Tiling切分原理与实战

使用Ascend C进行昇腾AI芯片算子开发,开发者仅需要把关注点放在数据切分和计算逻辑实现上。固定shape算子切分相对简单,动态shape的算子需要如何去实现呢?本篇笔记从复习切分的基本概念出发,讲述了一种动态shape的切分方法,并编程进行了验证。 ......

Spark 3.5.0 独立部署(Standalone)模式

1.下载Spark 3.5.0 https://spark.apache.org/downloads.html 2.安装JDK Linux 安装Openjdk 3.安装Hadoop Hadoop-3.3.6分布式集群搭建步骤 4.解压 mkdir /usr/spark tar -zxvf spark ......

spark与scala版本对应查看

https://mvnrepository.com/artifact/org.apache.spark/spark-core ......

为什么Spark比MapReduce快?

1、内存和磁盘使用方面 Spark vs MapReduce不等于内存 vs 磁盘,Spark和MapReduce的计算都发生在内存中,区别在于: MapReduce需要将每次计算的结果写入磁盘,然后再从磁盘读取数据,从而导致了频繁的磁盘IO。 Spark通常不需要将计算的结果写入磁盘,可以在内存中 ......

spark 3.0新特性

一、Adaptive Query Execution 自适应查询 https://blog.51cto.com/u_12865/7338853 二、Dynamic Partion Pruning 动态裁剪分区 Apache Spark 3.0 动态分区裁剪(Dynamic Partition Pru ......

Halcon 部分算子汇总一(calibration-adjust_mosaic_images.hdev)

1.tile_images_offset (多图像合并)Tile multiple image objects into a large image with explicit positioning information. 2.proj_match_points_ransac (确定两张图像间投 ......

详解Java编写并运行spark应用程序的方法WordCount_tyt2023

SparkContext:通往Spark集群的入口点,用于创建RDD和广播变量等 RDD:弹性分布式数据集,Spark应用程序的核心抽象 Transformation:操作RDD生成新的RDD,如map、filter等 Action:对RDD的操作,如count、collect等 环境:Spark ......

Spark 开发与应用_tyt2023

本实验基于MRS环境,主要介绍如何利用Spark RDD的常用算子进行简单统计分析,以及如何利用SparkSQL进行结构化批处理。 购买弹性公网IP 购买MRS集群 选择“自定义购买” 区域:华北—北京四 计费模式:按需计费 集群名称:mrs-bigdata 版本类型:普通版 集群版本:MRS 3. ......

Spark写hive insertInto和saveAsTable的差别和错误

insertInto必须保证源表字段顺序和hive表字段顺序一致,不然会插入乱序,如果字段数不一致,会报错 saveAsTable append模式下,如果字段数不一致,会报错,overwrite模式下,会重建表 如果是外部表,已经存在了数据,saveAsTable会报错 org.apache.sp ......

Hago 的 Spark on ACK 实践

长期以来,Hago 都是在 IDC 里运行大数据任务,以支撑上面的许多产品,从 2022 年开始,Hago 开始将大数据业务迁移上云,并以 Spark on ACK 的形式来运行,本文主要针对迁移过程进行介绍。 ......

Spark常用Sql

一、日期处理 1、查询当前日期 SELECT current_date() 2023-12-22 2、查询当前时间戳 select current_timestamp() 2023-12-22 14:50:19.213 3、查询当前时间戳-1小时 select current_timestamp() ......

Hive和Spark生产集群搭建

1.环境准备 1.1 版本选择 序号 bigdata-001 bigdata-002 bigdata-003 bigdata-004 bigdata-005 MySQL-8.0.31 mysql Datax Datax Datax Datax Datax Datax Spark-3.3.1 Spar ......

安装spark启动及遇到的问题

参考博主:Ubuntu下安装Spark3.2.0教程_ubuntu火狐浏览器怎么下载spark-CSDN博客 在这个博主的内容中安装spark,要注意滴是: 这里同时修改了spark-evn.sh的文件名称记得修改,然后下面 运行的时候我啥结果也没有,后面直接不管了打算执行命令:spark-shel ......

[spark] coalesce() 和 repartition()的区别

coalesce(1) 的主要作用是将数据合并到尽可能少的分区中,而 repartition(1) 则是将数据随机重分区为一个分区。这使得 coalesce(1) 相对而言更加高效,因为它减少了数据移动的次数,只需要在当前 Executor 上将所有分区的数据都收集到当前应用程序的单个 Execut ......

13-scharr与lapkacian算子

1.scharr与lapkacian算子: 2.Sobel算子、Scharr算子、Laplacian算子不同的描述: ......

Iceberg Spark存储过程-表治理工具

一、简介 存储过程(Procedure)是数据库领域的概念,类似于编程语言中的方法或函数,是对实现特定操作的封装,原生的 Spark SQL 中是不支持存储过程的,Iceberg 0.11.0版本之后对其进行了扩展,并提供了部分存储过程的实现。Iceberg 中提供的所有存储过程都在system n ......

编译器上手指南,算子开发及开源项目指导手册,直播课程报名通道限时开启!

本期既有技术大佬带来深度学习编译器 MegCC 的详细教程,又有实习经历丰富的在校同学分享 MegEngine 算子开发流程及开源经历,手把手带你学习,精彩不容错过!更有直播间有奖答疑, 现在报名,即有机会获得 MegEngine 周边大礼包! ......

spark-sql查询Iceberg时处理流程

1、查询表结构 show create table data_lake_ods.test CREATE TABLE spark_catalog.data_lake_ods.test ( `user_number` BIGINT NOT NULL, `subclazz_number` BIGINT N ......

spark提交文件支持路径类型

spark-submit 提交文件支持的路径类型 类似以下参数 --files --jars --archives --conf spark.yarn.jars --conf spark.yarn.archive --conf spark.yarn.dist.archives --conf spar ......

spark提交参数 [spark.yarn.dist.jars] 和 [spark.yarn.jars ]区别

spark.yarn.dist.jars 作用 用于指定分发到集群节点上的 JAR 包的路径。 工作原理 Spark 应用程序的执行器会将这些 JAR 包分发到它们的本地文件系统上。这样,应用程序可以在执行期间访问这些 JAR 包。 使用场景 适用于应用程序的依赖项,这些依赖项不需要在整个集群中共享 ......

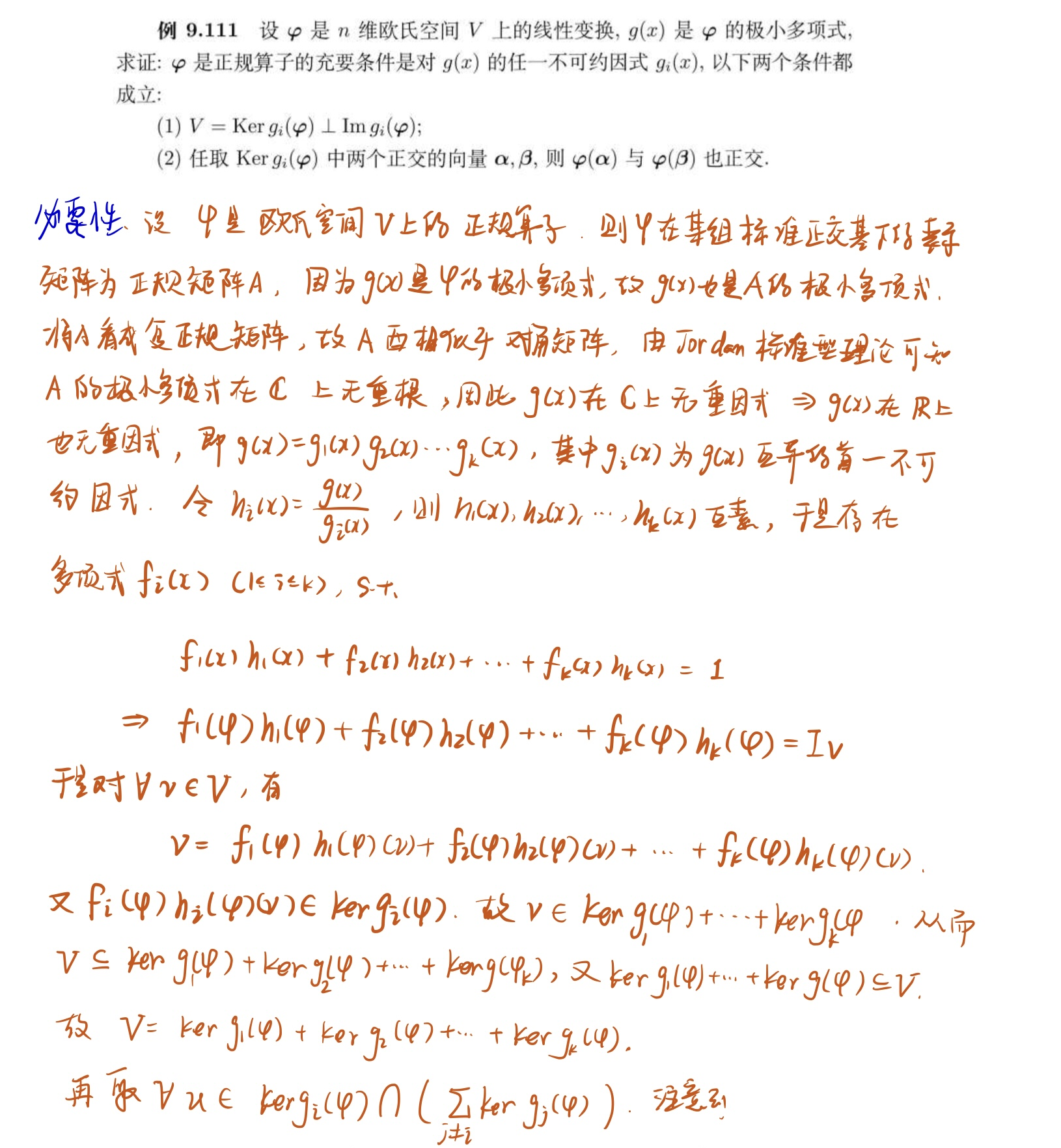

欧氏空间上正规算子极小多项式的不可约分解诱导出全空间的正交直和分解

{ JavaSparkContext jav ......

spark的shuffle和mapreduce的shuffle的区别

功能上,MR的shuffle和Spark的shuffle是没啥区别的,都是对Map端的数据进行分区,要么聚合排序,要么不聚合排序,然后Reduce端或者下一个调度阶段进行拉取数据,完成map端到reduce端的数据传输功能。 方案上,有很大的区别,MR的shuffle是基于合并排序的思想,在数据进入 ......

spark的excutor是动态的资源分配吗,还是写死的?

在Apache Spark中,Executor的资源分配可以是动态的,而不是写死的。Apache Spark提供了一种称为动态资源分配(Dynamic Allocation)的机制,允许根据应用程序的实际需求动态调整Executor的数量。 动态资源分配的主要思想是根据当前应用程序的工作负载来增加或 ......

Apache Spark 认证绕过漏洞(CVE-2020-9480)研究

一、Apache Spark简介 Spark是一种快速、通用、可扩展的大数据分析引擎,2009年诞生于加州大学伯克利分校AMPLab,2010年开源,2013年6月成为Apache孵化项目,2014年2月成为Apache顶级项目。项目是用Scala进行编写。 目前,Spark生态系统已经发展成为一个 ......

数仓实时算子难以观测,快来试试算子级监控吧

本文分享自华为云社区《GaussDB(DWS)监控工具指南(四)算子级监控【绽放吧!GaussDB(DWS)云原生数仓】》,作者: 幕后小黑爪 。 随着数据量的增大和数据处理的复杂性增加,数据库系统的性能问题变得越来越突出。应用程序对数据库的访问频率和数据量也越来越大。因此,优化数据库系统的性能成为 ......