p-tuning chatglm tuning

ChatGLM3本地部署

如何用免费GPU线上跑AI项目实践 - 飞书云文档 (feishu.cn) 准备步骤: 1.配置好环境pytorch2.0.1 python3.9 2.进入JupyterLab进入开发环境 3.将glm3从开源项目中git下来,这里在terminal输入指令后,输入github的账号密码进行git。 ......

Langchain-Chatchat项目:4.2-P-Tuning v2使用的数据集

本文主要介绍P-tuning-v2论文中的5种任务,分别为Glue任务、NER任务、QA任务、SRL任务、SuperGlue任务,重点介绍了下每种任务使用的数据集。 一.Glue任务 GLUE(General Language Understanding Evaluation)是纽约大学、华盛顿大学 ......

Langchain-Chatchat项目:4.1-P-Tuning v2实现过程

常见参数高效微调方法(Parameter-Efficient Fine-Tuning,PEFT)有哪些呢?主要是Prompt系列和LoRA系列。本文主要介绍P-Tuning v2微调方法。如下所示: Prompt系列比如,Prefix Tuning(2021.01-Stanford)、Prompt ......

使用 Sealos 将 ChatGLM3 接入 FastGPT,打造完全私有化 AI 客服

FastGPT 是一款专为客服问答场景而定制的开箱即用的 AI 知识库问答系统。该系统具备可视化工作流功能,允许用户灵活地设计复杂的问答流程,几乎能满足各种客服需求。 在国内市场环境下,离线部署对于企业客户尤为重要。由于数据安全和隐私保护的考虑,企业通常不愿意将敏感数据上传到线上大型 AI 模型 ( ......

使用单卡v100 32g或更低显存的卡,使用peft工具qlora或lora混合精度训练大模型chatGLM2-6b,torch混合精度加速稳定训练,解决qlora loss变成nan的问题!

最近新换了工作,以后的工作内容会和大模型相关,所以先抽空跑了一下chatGLM2-6b的demo,使用Qlora或lora微调模型 今天简单写个文档记录一下,顺便也是一个简单的教程,并且踩了qlora loss变成nan训练不稳定的问题 本教程并没有写lora的原理,需要的话自行查阅 1.chatG ......

转:ChatGLM3-6B测评

全新ChatGLM3-6B针对七项RAG能力的评测,谁最适合RAG? 原创 这个男人来自千祥 土猛的员外 2023-10-30 17:32 发表于浙江 https://mp.weixin.qq.com/s/6fnZt2sBTakfXZMcS-scPA 1.实体提取 实体和关系提取当然也可以使用NER ......

大语言模型Fine-tuning踩坑经验之谈

前言 由于 ChatGPT 和 GPT4 兴起,如何让人人都用上这种大模型,是目前 AI 领域最活跃的事情。当下开源的 LLM(Large language model)非常多,可谓是百模大战。面对诸多开源本地模型,根据自己的需求,选择适合自己的基座模型和参数量很重要。选择完后需要对训练数据进行预处 ......

python 部署chatglm2b

下载模型实现 然后手动下载模型 GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/THUDM/chatglm2-6b cd ChatGLM2-6B mkdir modelsglm && cd modelsglm vim downs.py # ......

深度学习调参手册(Deep Learning Tuning Playbook)

google-research/tuning_playbook: A playbook for systematically maximizing the performance of deep learning models. (github.com) dkhonker/tuning_playbo ......

课程二第三周:Hyperparameter tuning, Batch Normalization and Programming Frameworks

Hyperparameter tuning Tuning process 到目前为止,接触到的超参数有: 学习效率learning-rate:\(\alpha\) Momentum算法的参数:\(\beta\) 加权平均的参数 Adam算法的参数:\(\beta_1、\beta_2、\epsilon ......

LLM探索:为ChatGLM2的gRPC后端增加连续对话功能

前言 之前我做 AIHub 的时候通过 gRPC 的方式接入了 ChatGLM 等开源大模型,对于大模型这块我搞了个 StarAI 框架,相当于简化版的 langchain ,可以比较方便的把各种大模型和相关配套组合在一起使用。 主要思路还是用的 OpenAI 接口的那套,降低学习成本,但之前为了快 ......

教你如何基于MindSpore进行ChatGLM微调

本文分享自华为云社区《基于MindSpore的ChatGLM微调》,作者: JeffDing 。 基于MindSpore的ChatGLM微调 克隆Hugging Face模型 克隆chatglm-6b代码仓,下载分布式的模型文件 git lfs install git clone https://h ......

基于 P-Tuning v2 进行 ChatGLM2-6B 微调实践

微调类型简介 1. SFT监督微调:适用于在源任务中具有较高性能的模型进行微调,学习率较小。常见任务包括中文实体识别、语言模型训练、UIE模型微调。优点是可以快速适应目标任务,但缺点是可能需要较长的训练时间和大量数据。 2. LoRA微调:通过高阶矩阵秩的分解减少微调参数量,不改变预训练模型参数,新 ......

【开源】给ChatGLM写个,Java对接的SDK

作者:小傅哥 - 百度搜 小傅哥bugstack 博客:bugstack.cn 沉淀、分享、成长,让自己和他人都能有所收获!😄 大家好,我是技术UP主小傅哥。 清华大学计算机系的超大规模训练模型 ChatGLM-130B 使用效果非常牛,所以我也想把这样的Ai能力接入到自己的应用中或者做一些 In ......

Langchain-Chatchat项目:1.1-ChatGLM2项目整体介绍

ChatGLM2-6B是开源中英双语对话模型ChatGLM-6B的第2代版本,引入新的特性包括更长的上下文(基于FlashAttention技术,将基座模型的上下文长度由ChatGLM-6B的2K扩展到了32K,并在对话阶段使用8K的上下文长度训练);更高效的推理(基于Multi-QueryAtte ......

ChatGLM2

下载chatglm2-6b print('开始加载分词器tokenizer...') tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm2-6b", trust_remote_code=True) print('开始加载语言模型model ......

ChatGLM-6B-PT微调

目录开发环境ChatGLM2-6B源码下载模型安装依赖下载ADGEN数据集微调前修改训练步数微调后 开发环境 矩池云 https://www.matpool.com/host-market/gpu ChatGLM2-6B源码 https://github.com/THUDM/ChatGLM2-6B ......

使用Triton部署chatglm2-6b模型

一、技术介绍 NVIDIA Triton Inference Server是一个针对CPU和GPU进行优化的云端和推理的解决方案。 支持的模型类型包括TensorRT、TensorFlow、PyTorch(meta-llama/Llama-2-7b)、Python(chatglm)、ONNX Run ......

本地部署 Langchain-Chatchat & ChatGLM

一、模型&环境介绍 1. ChatGLM github 地址:https://github.com/THUDM 模型地址:https://huggingface.co/THUDM 2. m3e 模型地址:https://huggingface.co/moka-ai/m3e-base/ 3. text ......

LangChain使用fine-tuned GPT-3.5

LangChain使用fine-tuned GPT-3.5 参考: https://openai.com/blog/gpt-3-5-turbo-fine-tuning-and-api-updates https://platform.openai.com/docs/guides/fine-tunin ......

16G内存+CPU本地部署ChatGLM2/Baichuan2推理(Windows/Mac/Linux)

概述 本文使用chatglm.cpp对中文大语言模型(LLM)进行量化与推理,支持ChatGLM2-6B、Baichuan2-13B-Chat等模型在CPU环境16G内存的个人电脑上部署,实现类似ChatGPT的聊天功能。支持的操作系统包括Windows、Mac OS、Linux等。 其中,量化过程 ......

解决 ChatGLM.CPP+clBlast 编译错误(也适用于SD.CPP)

首先安装 OpenCL 和 clblast: vcpkg install opencl clblast 下载GitHub 上的源码: git clone --recurse-submodules https://github.com/li-plus/chatglm.cpp cd chatglm.cp ......

CF498B Name That Tune

好像和题解不太一样。 令 \(f_{i,j}\) 为第 \(j\) 秒末识别出第 \(i\) 首歌的概率。那么答案就是 \(\sum\limits_{i=1}^n\sum\limits_{j=1}^Tf_{i,j}\)。 转移分两种: 听完了这首歌都没识别出,此时算是识别出这首歌了,\(f_{i,j ......

chatglm2-6b在P40上做LORA微调

目前,大模型的技术应用已经遍地开花。最快的应用方式无非是利用自有垂直领域的数据进行模型微调。chatglm2-6b在国内开源的大模型上,效果比较突出。本文章分享的内容是用chatglm2-6b模型在集团EA的P40机器上进行垂直领域的LORA微调。 ......

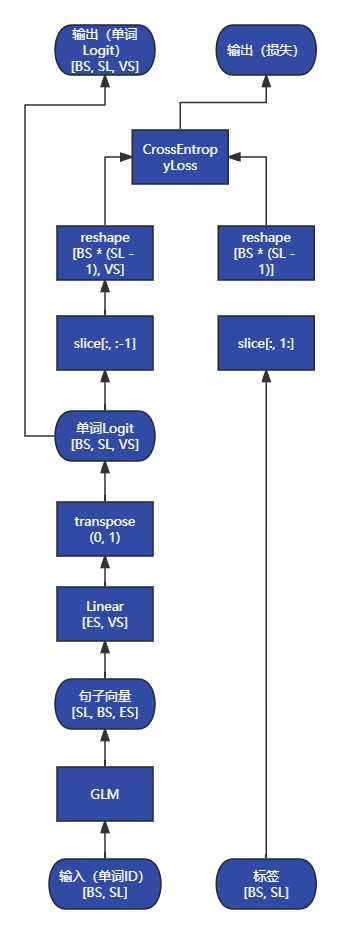

ChatGLM2 源码解析:`ChatGLMForConditionalGeneration.forward`

```py class ChatGLMForConditionalGeneration(ChatGLMPreTr ......

ChatGLM2 源码解析:`ChatGLMModel`

```py # 完整的 GLM 模型,包括嵌入层、编码器、输出层 class ChatGLMModel(ChatG ......

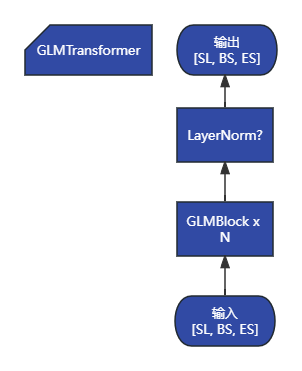

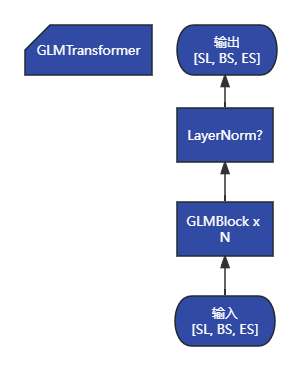

ChatGLM2 源码解析:`GLMTransformer`

```py # 编码器模块,包含所有 GLM 块 class GLMTransformer(torch.nn.Mo ......

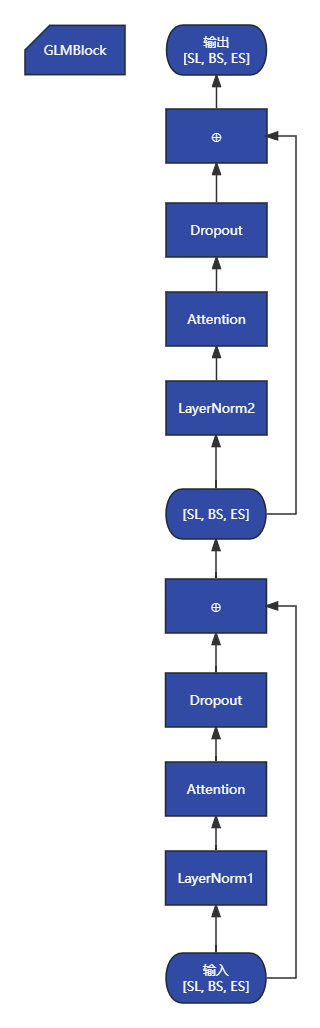

ChatGLM2 源码解析:`GLMBlock`

```py # GLM 块包括注意力层、FFN层和之间的残差 class GLMBlock(torch.nn.Mo ......

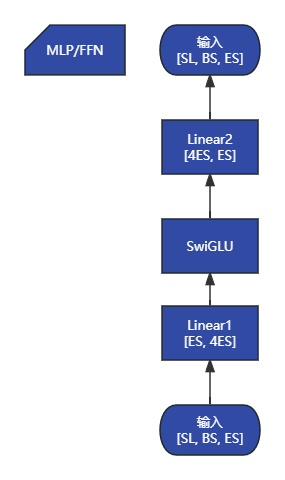

ChatGLM2 源码解析:`MLP`

```py class MLP(torch.nn.Module): """MLP. MLP will take ......

论文解读(AdSPT)《Adversarial Soft Prompt Tuning for Cross-Domain Sentiment Analysis》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Adversarial Soft Prompt Tuning for Cross-Domain Sentiment Analysis论文作者:Hui Wu、Xiaodong Shi论文来源:2022 ACL ......