crossformer cross-scale transformer attention

Transformer模型

### Transformer模型 [Transformer模型及其实现](https://blog.csdn.net/moo611/article/details/122234867) 历史:谷歌团队在2017年提出的经典NLP模型(目前很火的bert模型就是基于此模型)。 特点:Transfor ......

CF623E Transforming Sequence

难点在于卡 `__int128`(?)。 首先 $N>K$ 显然无解,只需考虑 $N\le K$ 的情况。然而这并没有什么用。 把 $b$ 看作集合,显然 $b_i\subset b_{i+1}$。所以令 $f_{n,i}$ 为考虑到 $b_n$ 且 $|b_n|=i$ 的方案数,集合元素无序,即选 ......

VBA利用transform函数和ADO实现交叉汇总

VBA中transform函数基本语法: Creates a crosstab query. Syntax TRANSFORM aggfunction selectstatement PIVOT pivotfield [IN (value1[, value2[, ...]])] The TRANSF ......

Vision Transformer

Vision Transformer 本文关注ViT论文`4.5 Inspecting Vision Transformer`可视化的原理及实现,此外还对ViT pytorch源码实现进行理解 [toc] # Introduction [论文地址](arXiv:2010.11929) ## Titl ......

transformer中解码器的实现细节

1. 前言 17年google团队发表l了论文《Attention Is All You Need》,transformer横空出世,并引领了AI学术圈的研发风向,以Transformer为基础模型的新模型层出不穷,无论是NLP还是CV或者是多模态,attention遍地开花。 这篇文章遵循enco ......

Transformer(转换器)

Sequence To Sequence(序列对序列) 输入一个序列,输出一个序列 输出序列的长度由机器自己决定,例如:语音辨识、机器翻译、语音翻译 Sequence To Sequence一般分成两部分: Encoder:传入一个序列,由Encoder处理后传给Decoder Decoder:决定 ......

斯坦福博士一己之力让Attention提速9倍!FlashAttention燃爆显存,Transformer上下文长度史诗级提升

前言 FlashAttention新升级!斯坦福博士一人重写算法,第二代实现了最高9倍速提升。 本文转载自新智元 仅用于学术分享,若侵权请联系删除 欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。 CV各大方向专栏与各个部署框架最全教程整理 【CV技 ......

self-attention

Self attention考虑了整个sequence的资讯【transfermer中重要的架构是self-attention】 解决sequence2sequence的问题,考虑前后文 I saw a saw 第一个saw对应输出动词 第二个输出名词 如何计算相关性【attention score ......

Transformer取代者登场!微软、清华刚推出RetNet:成本低、速度快、性能强

前言 Transformer 的训练并行性是以低效推理为代价的:每一步的复杂度为 O (N) 且键值缓存受内存限制,让 Transformer 不适合部署。不断增长的序列长度会增加 GPU 内存消耗和延迟,并降低推理速度。研究者们一直在努力开发下一代架构,希望保留训练并行性和 Transformer ......

[未解决] vue transform-blocks解析源代码报错:Illegal tag name. Use '<' to print '<'.

报错内容: [vite] Internal server error: Illegal tag name. Use '<' to print '`标签后报错,但其他vue文件可以正常读取和展示。 报错的文件,去掉``标签就可以正常加载。报错的方法是vue-compiler的`baseParse()` ......

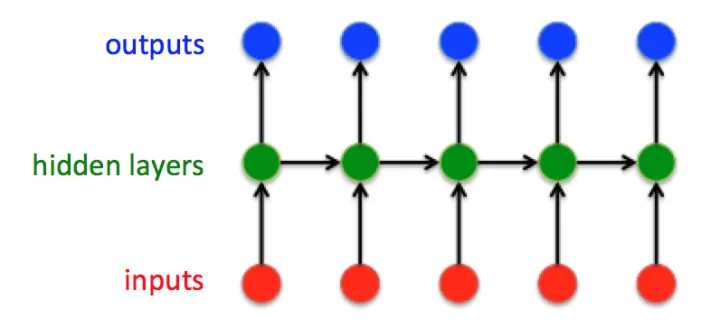

从RNN到Transformer

## 1. RNN 循环神经网络的内容可参考https://www.youtube.com/watch?v=UNmqTiOnRfg。 RNN建模的对象是具有时间上前后依赖关系的对象。以youtube上的这个视频为例,一个厨师如果只根据天气来决定今天他做什么菜,那么就是一个普通的神经网络;但如果他第i ......

Hugging News #0717: 开源大模型榜单更新、音频 Transformers 课程完成发布!

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。本期 Hugging News 有哪些有趣的消息,快来看看吧! 🎉 😍 ## 重磅更新 ......

大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍

# 大语言模型的预训练[1]:基本概念原理、神经网络的语言模型、Transformer模型原理详解、Bert模型原理介绍 # 1.大语言模型的预训练 ## 1.LLM预训练的基本概念 预训练属于迁移学习的范畴。现有的神经网络在进行训练时,一般基于反向传播(Back Propagation,BP)算法 ......

Transform LiveData

查询资料的其中一个场景: 创建一个回调函数,当查询后台的时候,后台有结果了,回调对应的回调函数,并将结果保存到LiveData中。 public class DataModel { ... public MutableLiveData<List<Repo>> searchRepo(String qu ......

[论文速览] A Closer Look at Self-supervised Lightweight Vision Transformers

## Pre title: A Closer Look at Self-supervised Lightweight Vision Transformers accepted: ICML 2023 paper: https://arxiv.org/abs/2205.14443 code: https ......

论文日记四:Transformer(论文解读+NLP、CV项目实战)

# 导读 重磅模型**transformer**,在2017年发布,但就今天来说产生的影响在各个领域包括NLP、CV这些都是巨大的! Paper《[Attention Is All You Need](https://arxiv.org/pdf/1706.03762.pdf)》,作者是在机器翻译这个 ......

seq2seq+attention的个人理解

[toc] ## RNN 经典的RNN结构:  这是经典的RNN结构,输入向量是:  ## Introd ......

我用numpy实现了VIT,手写vision transformer, 可在树莓派上运行,在hugging face上训练模型保存参数成numpy格式,纯numpy实现

先复制一点知乎上的内容 按照上面的流程图,一个ViT block可以分为以下几个步骤 (1) patch embedding:例如输入图片大小为224x224,将图片分为固定大小的patch,patch大小为16x16,则每张图像会生成224x224/16x16=196个patch,即输入序列长度为 ......

transformer

arXiv:1706.03762 # 1. 问题提出 全连接神经网络(FCN),可以很好的处理输入为1个向量(特征向量)的情况,但是如果输入是一组向量,FCN处理起来不太方便 以词性标记的问题为例 对于处于同一个句子中的相同的2个单词`saw`,词性不同,前者为动词(V),后者为名词(N) 如果尝试 ......

Transformer学习笔记

[09 Transformer 之什么是注意力机制(Attention)@水导](https://www.bilibili.com/video/BV1QW4y167iq) [ELMo原理解析及简单上手使用@知乎](https://zhuanlan.zhihu.com/p/51679783) ELMo ......

【论文阅读】CrossViT:Cross-Attention Multi-Scale Vision Transformer for Image Classification

> # 🚩前言 > > - 🐳博客主页:😚[睡晚不猿序程](https://www.cnblogs.com/whp135/)😚 > - ⌚首发时间:23.7.10 > - ⏰最近更新时间:23.7.10 > - 🙆本文由 **睡晚不猿序程** 原创 > - 🤡作者是蒻蒟本蒟,如果文章里有 ......

N9、Transformer实战-单词预测

🍨 本文为🔗365天深度学习训练营 中的学习记录博客 🍖 原作者:K同学啊 | 接辅导、项目定制 🚀 文章来源:K同学的学习圈子 📌 本周任务: 理解文中代码逻辑并成功运行 自定义输入一段英文文本进行预测(拓展内容,可自由发挥) 数据:Wikitext-2数据集 WikiText 英语词库 ......

Multi-Modal Attention Network Learning for Semantic Source Code Retrieval 解读

# Multi-Modal Attention Network Learning for Semantic Source Code Retrieva Multi-Modal Attention Network Learning for Semantic Source Code Retrieval,题 ......

【论文阅读】CrossFormer: A Versatile Vision Transformer Based on Cross-scale Attention

来自CVPR 2021 论文地址:https://link.zhihu.com/?target=https%3A//arxiv.org/pdf/2108.00154.pdf 代码地址:https://link.zhihu.com/?target=https%3A//github.com/cheers ......

NLP | Transformers回顾 :从BERT到GPT4

人工智能已成为近年来最受关注的话题之一,由于神经网络的发展,曾经被认为纯粹是科幻小说中的服务现在正在成为现实。从对话代理到媒体内容生成,人工智能正在改变我们与技术互动的方式。特别是机器学习 (ML) 模型在自然语言处理 (NLP) 领域取得了重大进展。一个关键的突破是引入了“自注意力”和用于序列处理 ......