tensorflow-keras tensorflow keras gpu

TensorFlow09.1 神经网络-其他训练Tricks(Early Stopping和Dropout)

Tricks ▪ Early Stopping ▪ Dropout ▪ Stochastic Gradient Descent # 1 Early stopping 我们走到最大指的时候我们可以提交stop掉,防止它overfitting。

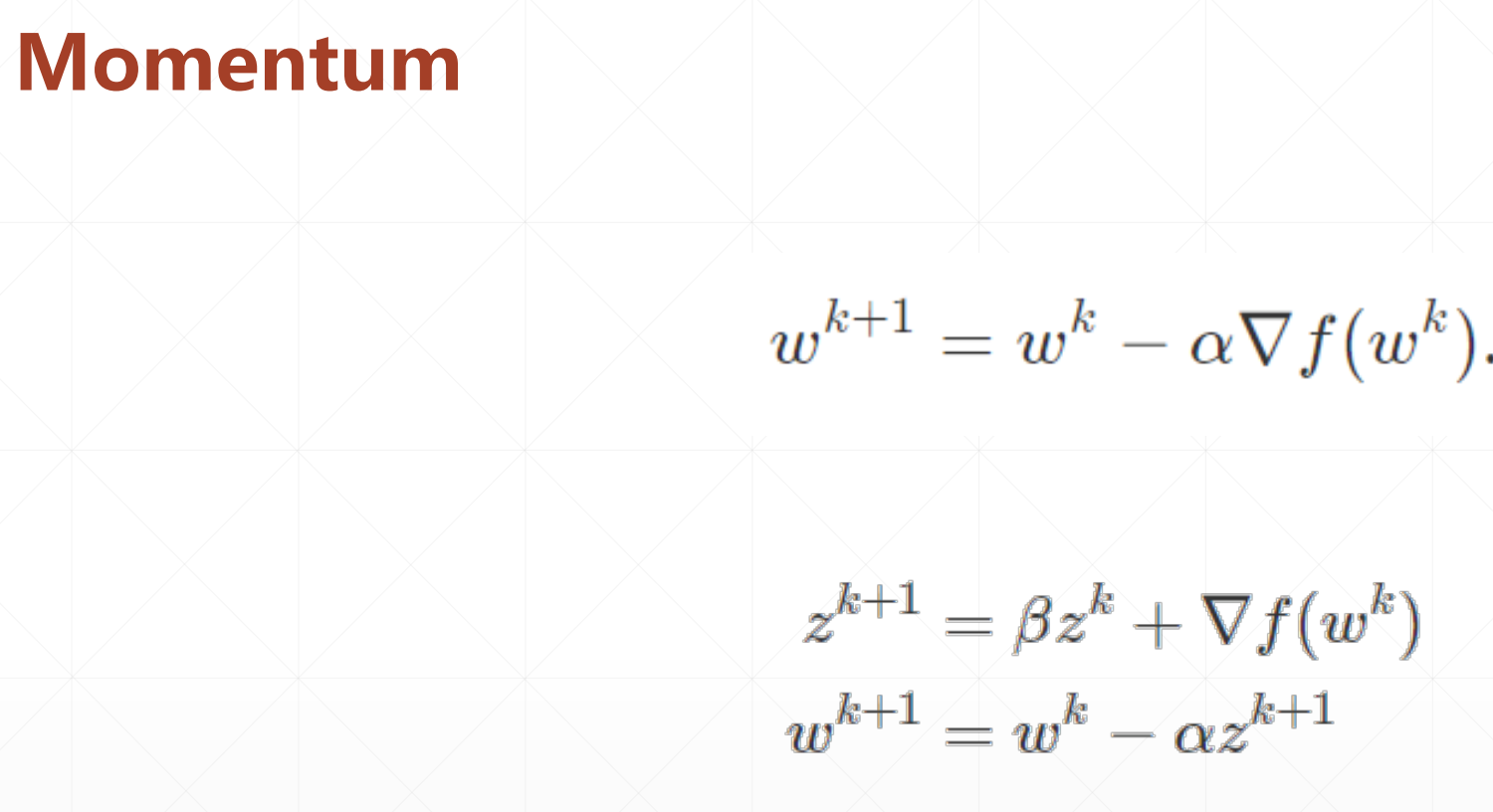

▪ momentum(动量,惯性) ▪ learning rate decay # 1 momentum  分 ......

TensorFlow08 神经网络-过拟合与欠拟合、交叉验证与解决方法。

# 1 过拟合和欠拟合 线性模型  非线性模型  这个照片很模糊,大小只有[32,32],所以我们预测的结果也不是很好。 # 2 自定义 ......

pytorch 使用多GPU训练模型测试出现:TypeError: forward() missing 1 required positional argument: ‘x‘可能解决方法

转载:https://blog.csdn.net/lingyunxianhe/article/details/119454778?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522168718901716800227455818%2522 ......

TensorFlow08 神经网络-模型的保存和加载

一般情况下有三种方式: ▪ save/load weights(只保存网络的参数,状态不管) ▪ save/load entire model(把所有的状态都保存) ▪ saved_model(交给工厂的时候可以用,可以跨语言) # 1 save/load weights 比如说你的网络里面有[w1 ......

GPU(图形处理器)探索

序章 图形处理器(英语:graphics processing unit,缩写:GPU),又称显示核心、视觉处理器、显示芯片,是一种专门在个人电脑、工作站、游戏机和一些移动设备(如平板电脑、智能手机等)上做图像和图形相关运算工作的微处理器。 GPU 是 显卡(Video card、Display c ......

TensorFlow07 神经网络-自定义网络

▪ keras.Sequential ▪ keras.layers.Layer ▪ keras.Model # 1 keras.Sequential

[TOC] # 为什么是TensorFlow ## PyTorch 是什么 是基于以下两个目的而打造的python科学计算框架: ```c 无缝替换NumPy,并且通过利用GPU的算力来实现神经网络的加速。 通过自动微分机制,来让神经网络的实现变得更加容易。 ``` ## 使用 TensorFlow ......

浅析GPU架构与异构计算CUDA

下图有几个重点的元素,也是我们下文重点要阐述的概念,绿色代表的是computational units(可计算单元) 或者称之为 cores(核心),橙色代表memories(内存) ,黄色代表的是control units(控制单元)。 因此想要理解GPU的底层核心构成,就必须明确这几个元素的作用 ......

unity发布后GPU占用过高

发布后显示GPU占用98%,太夸张了吧 同工程哪怕是空场景也是占用很高,除非新建工程 对比很久才发现,是垂直同步的问题,场景质量为最低的时候,不开垂直同步反而增大了性能消耗,包括CPU https://zhuanlan.zhihu.com/p/453296774 ......

Centos 7.8 中安装Nvidia A100 GPU驱动

Centos7安装A100显卡驱动 https://blog.csdn.net/yaxuan88521/article/details/123989543 开启MIG模式命令: nvidia-smi -mig 1 ......

TensorFlow06 kearas高级API

Keras != tf.keras ▪ datasets ▪ layers ▪ losses **▪ metrics(主要)** ▪ optimizers # 1 Keras.Metrics 1.Metrics(新建一个Matrics) 2.update_state(添加数据) 3.result() ......

TensorFlow05.3 神经网络-FashionMNIST实战

一.数据的加载: ``` (x, y), (x_test, y_test) = datasets.fashion_mnist.load_data() print(x.shape, y.shape) ```

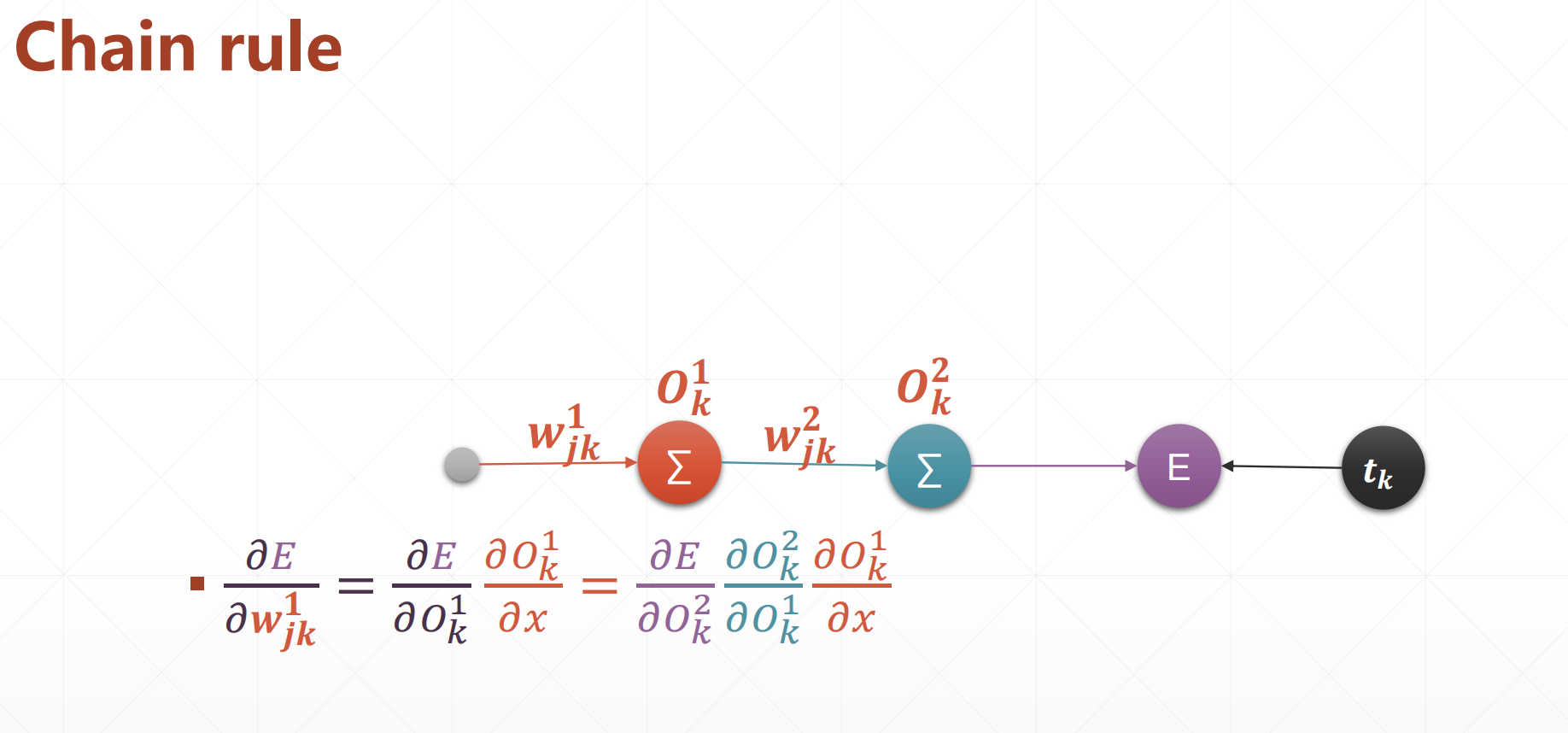

首先这个是链式法则:   # 1 Basic Rule   梯度是一个向量 的博客,启发了idea,成功改进了线上的一款模型。想法产出和实验进展很大一部分得益于苏神设计的bert4keras,清晰轻量、基于keras,可以很简洁的实现bert,同时附上了很多 ......

TensorFlow05-3 神经网络损失函数(误差计算)

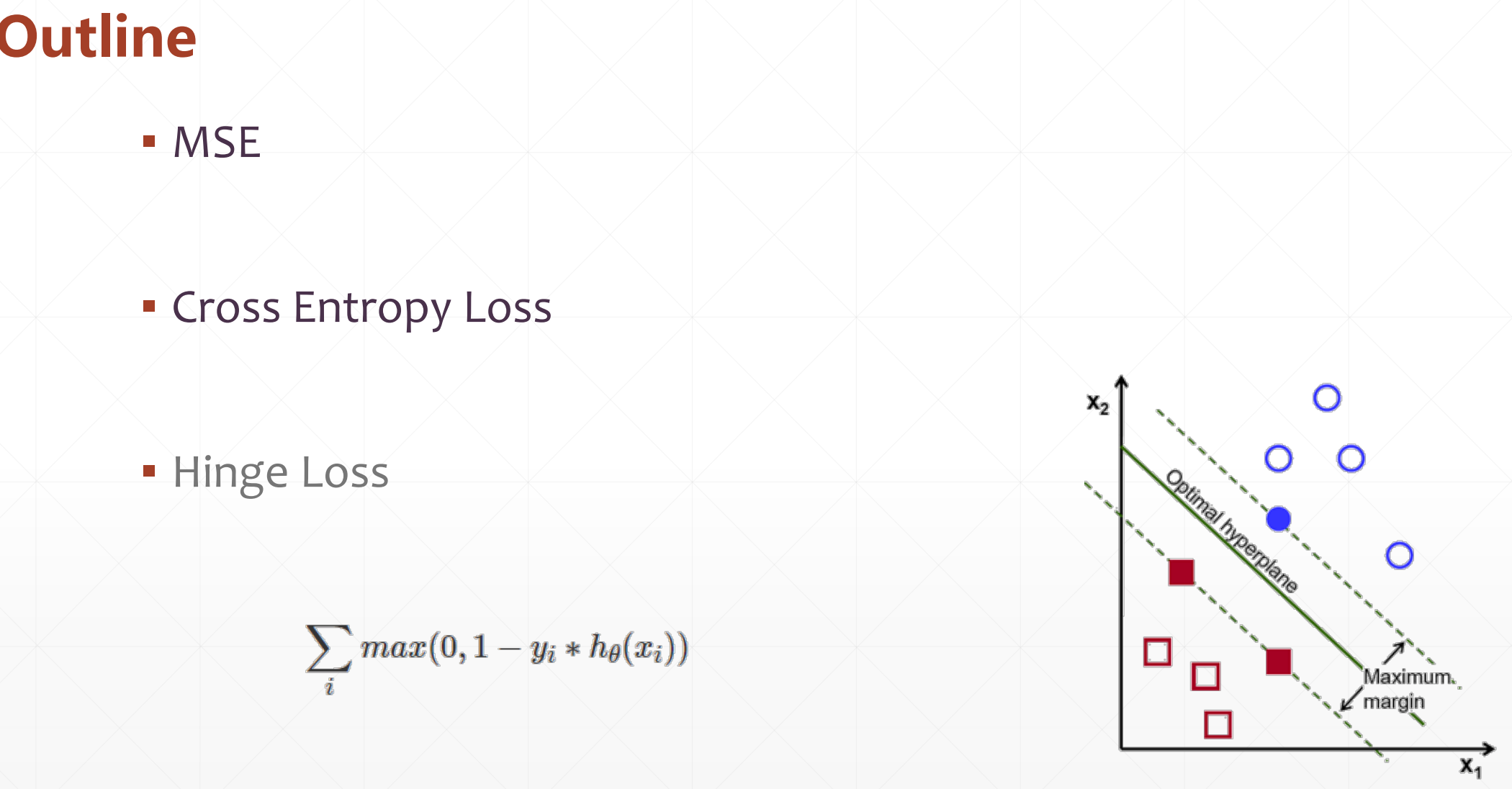

▪ MSE ▪ Cross Entropy Loss(针对分类问题) ▪ Hinge Loss  # 1 ......

TensorFlow05.2-神经网络输出方式

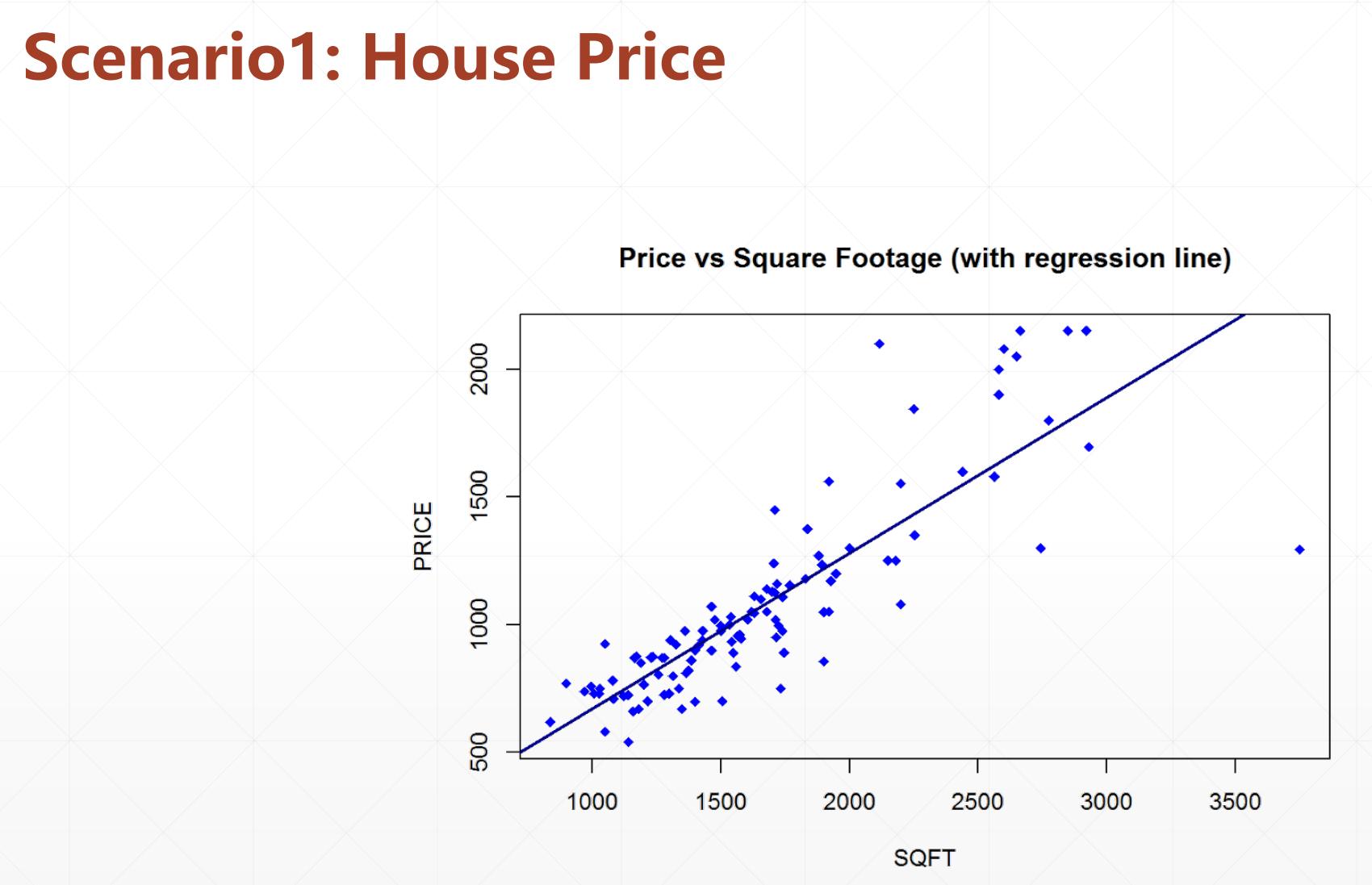

这里的输出方式有这几种:  # 1 𝑦∈𝑅^d ▪ linear regression(线性回归) ......

TensorFlow05-全连接层

▪ Matmul ▪ Neural Network ▪ Deep Learning ▪ Multi-Layer # 1.Matmul - out=f(x@w+b) - out=relu(x@w+b)  2.tf.data.Dataset.from_tensor_slices(加载成tensor) - shuffle - map - batch - repeat # 2 tf.keras.datasets()  则是大规模计算和并行计算中最常用的计算硬件之一。本文将介绍 GPU 技术在大规模计算和并行计算 ......

在 WSL 里启用 GPU 加速

适用于Windows10, Ubuntu, NVIDIA GeForce MX450 # STEP 1: WSL1 升级 WLS2 CUDA 仅支持 WSL2:( 步骤:https://zhuanlan.zhihu.com/p/356397851 **Q1**:`sudo apt get wsl` ......

Pytorch中查看GPU信息

本文摘自:知乎 用Pytorch中查看GPU信息 1. 返回当前设备索引 torch.cuda.current_device() 2. 返回GPU的数量 torch.cuda.device_count() 3. 返回gpu名字,设备索引默认从0开始 torch.cuda.get_device_nam ......

R语言深度学习:用keras神经网络回归模型预测时间序列数据|附代码数据

library(keras) 生成样本数据集 首先,本教程的样本回归时间序列数据集。 plot( c ) points( a ) points( b ) points( y ) 点击标题查阅往期内容 RNN循环神经网络 、LSTM长短期记忆网络实现时间序列长期利率预测 左右滑动查看更多 01 02 ......

GPU技术在大规模数据集处理和大规模计算中的应用

[toc] 32. GPU 技术在大规模数据集处理和大规模计算中的应用 随着深度学习在人工智能领域的快速发展,大规模数据处理和大规模计算的需求日益增长。GPU(图形处理器)作为现代计算机的重要部件,被广泛应用于这些领域,尤其是在深度学习模型的训练和推理中。在本文中,我们将介绍 GPU 技术在大规模数 ......

GPU技术在大规模计算和并行计算中的应用和挑战

[toc] 44. GPU 技术在大规模计算和并行计算中的应用和挑战 随着计算机硬件的不断发展和计算能力的提高,大规模计算和并行计算已经成为了人工智能和机器学习领域的重要研究方向。而 GPU(图形处理器) 则是大规模计算和并行计算中最常用的计算硬件之一。本文将介绍 GPU 技术在大规模计算和并行计算 ......