Planning

Leveraging Pre-trained Large Language Models to Construct and UtilizeWorld Models for Model-based Task Planning

0 Abstract 将LLM直接作为planner的方法实用性不足的几个原因:plan的正确率有限,严重依赖于feedback(与sim或者真实环境的交互),利用人类feedback的效率低下。 作者在两个IPC域和一个Household域证实了GPT-4可以用来生成高质量的PDDL模型(执行超过 ......

NOMURA Programming Competition 2020 D Urban Planning

考虑排列 \(P_i\) 已经固定了的情况,那么连边 \(i\to P_i\) 形成有向图 \(G\),最小连边数就是 \(N\) 减去弱连通块数。善良的出题人已经告诉你连边方案就是 \((N-1)^K\),所以答案就是 \(N(N-1)^K\) 减去所有连边方案中弱连通块数量总和。于是只需要考虑所 ......

picnic planning证明

首先最终的答案一定包含最开始的T条边,不然的话,我们选择这T条边中没被包含的任意一条边,把它加入现有的生成树 由于这T条边连接的是不同的连通块,所以加入这条边后生成树会形成一个环,而且这个环除了这一条边不包含其他任何一条这T条边中的一边 又因为这T条边是最小的T条边,我们选择这个环上从1出发的不是这 ......

题解 UVA1537 Picnic Planning

这道题在显然是最小生成树,但是很显然我是不会打最小生成树的。 题意描述 给定一张 \(n\) 个点 \(m\) 条边的无向图,求出无向图的一棵最小生成树,满足一号节点的度数不超过给定的整数 \(s\)。 具体思路 首先,看到这种度数最多为 \(s\) 的题,显然想到 wqs 二分。但是 wqs 二分 ......

Intention-Aware Online POMDP Planning for Autonomous Driving in a Crowd

一、论文信息 发表日期:2015年 发表机构:新加坡国立大学,计算机科学系 二、论文内容 1.解决问题:无人车在人员密集处的速度规划算法 2.方法:前向仿真+强化学习概念 ①.路径规划和速度规划进行解耦,进行速度规划之前路径已确定。 ②.速度规划采取部分可观测马尔可夫决策过程,借用了强化学习的动作价 ......

题解 P7640 [BalticOI 2006 Day 2] CITY PLANNING

首先我们定义“圈”为与原点距离相等的点集。 ``` . . . 3 . . . . . 3 2 3 . . . 3 2 1 2 3 . 3 2 1 0 1 2 3 . 3 2 1 2 3 . . . 3 2 3 . . . . . 3 . . . ``` ### 暴力: 把圈放到堆里,然后每次取出代 ......

L11U3-1-Planning a trip

Planning a trip ## Dialogue 1.I've been planning this for so long. 2.I'm going to America. 3.I'm planning to hit all the big cities. 4.I intend to go ......

w task 2 - planning

spend 10 minutes planning your essay highlight key words plan your essay structure Introduction : .... (Topic) ... (Answer) benefits of A benefits of ......

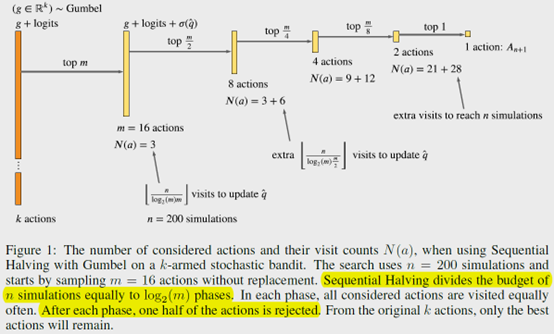

POLICY IMPROVEMENT BY PLANNING WITH GUMBEL

**发表时间:**2022(ICLR 2022) **文章要点:**AlphaZero在搜索次数很少的时候甚至动 ......

Apollo planning 模块(三):path decider

lane follow场景为例,包含一个stage,每个stage又包含若干个task。在路径决策方面,依次进行lane_change_decider、path_reuse_decider、path_lane_borrow_decider、path_bounds_decider。在路径优化方面,依次 ......

Apollo planning模块 (一)

1.Navigation模式 参考文档:/apollo-3.5.0/docs/howto/how_to_use_apollo_2.5_navigation_mode_cn.md 高精地图制作难度大、需要特殊权限,因此为了使Apollo系统摆脱对高精地图的依赖,设置了Navigation模式。Navi ......

EXPLORING MODEL-BASED PLANNING WITH POLICY NETWORKS

**发表时间:**2020(ICLR 2020) **文章要点:**这篇文章说现在的planning方法都是在动作空间里randomly generated,这样很不高效(其实瞎扯了,很多不是随机的方法啊)。作者提出在model based RL里用policy网络来做online planning ......

Learning Off-Policy with Online Planning

**发表时间:**2021(CoRL 2021) **文章要点:**这篇文章提出Off-Policy with Online Planning (LOOP)算法,将H-step lookahead with a learned model和terminal value function learne ......

Lecture#14 Query Planning & Optimization

SQL是声明性的,这意味着用户告诉 DBMS 他们想要什么答案,而不是如何得到答案。因此,DBMS 需要将 SQL 语句转换为可执行的查询计划。 但不同的查询计划的效率可能出现多个数量级的差别,如 Join Algorithms 一节中的 Simple Nested Loop Join 与 Hash ......

Codeforces Round 625 (Div. 1, based on Technocup 2020 Final Round) A. Journey Planning(dp)

https://codeforces.com/contest/1320/problem/A ###A. Journey Planning 题目大意: 给定一组数,问我们ai-aj==i-j的时候就可以把ai的值加起来,问我们可以凑到的最大总值是多少? input 6 10 7 1 9 10 15 o ......

The Predictron: End-To-End Learning and Planning

**发表时间:**2017(ICML 2017) **文章要点:**这篇文章设计了一个叫Predictron的结构,在abstract的状态上进行学习,通过multiple planning depths来使得model self-consistent,进行端对端的学习。这里的设定是MRP,不是MD ......

Learning model-based planning from scratch

**发表时间:**2017 **文章要点:**这篇文章想说,之前的文章去做planning的时候,都会去设计一个planning的方法。这篇文章提出了一个端到端的方法,Imagination-based Planner,不去设计planning的方式,做到全部的端对端训练,agent会决定什么时候去 ......