transformer spikformer network spiking

安装npm install报错npm ERR! code ETIMEDOUT npm ERR! errno ETIMEDOUT npm ERR! network request to https://registry.npmjs.org/webpack-subresource-integrity failed, reason

执行命令:npm run dev 启动前端项目报如下错误,vue-cli-service是Vue一个启动的插件,需要安装 D:\nodejs\npm.cmd run dev > yuntan1hao@2.0.0 dev > vue-cli-service serve --open 'vue-cli- ......

CF1506D - Epic Transformation

思路 用优先队列模拟 ac代码 #include <bits/stdc++.h> using namespace std; using i64 = long long; const i64 inf = 8e18; typedef pair<int, int> pii; const int N = 5 ......

Docker 数据库连接见解异常 SQLSTATE[HY000] [2002] php_network_getaddresses: getaddrinfo failed: Try again

Docker 配置 DNS { "builder": { "gc": { "defaultKeepStorage": "20GB", "enabled": true } }, "experimental": false, "features": { "buildkit": true }, "regi ......

LLM series: Transformer

🥥 Homepage Dataset, DataLoader, and Transforms Model Traning Model 🥑 Get Started! Import libraries: import torch import torch.nn as nn import torch. ......

Learning Dynamic Query Combinations for Transformer-based Object** Detection and Segmentation论文阅读笔记

Motivation & Intro 基于DETR的目标检测范式(语义分割的Maskformer也与之相似)通常会用到一系列固定的query,这些query是图像中目标对象位置和语义的全局先验。如果能够根据图像的语义信息调整query,就可以捕捉特定场景中物体位置和类别的分布。例如,当高级语义显示图 ......

[NLP复习笔记] Transformer

1. Transformer 概述 1.1 整体结构 \(\text{Transformer}\) 主要由 \(\text{Encoder}\) 和 \(\text{Decoder}\) 两个部分组成。\(\text{Encoder}\) 部分有 \(N = 6\) 个相同的层,每层包含 一个 \( ......

1.9 Rotated Multi-Scale Interaction Network for Referring Remote Sensing Image Segmentation 基于语义分割遥感图像的模型

Rotated Multi-Scale Interaction Network for Referring Remote Sensing Image Segmentation 参考遥感图像分割的旋转多尺度交互网络 参考遥感图像分割 (RRSIS)是一个新的挑战,它结合了计算机视觉和自然语言处理,通过 ......

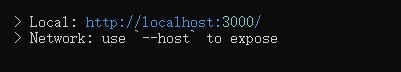

vite启动后提示:Network: use --host to expose,且无法通过网络IP访问服务

原因: 当 局域网 中另一台设备需要访问该服务时,必须通过本机 IP + 端口 访问。 尝试访问后,发现找不到这个 ......

RNN 和 Transformer 复杂度比较

这里假设BatchSize为 1,就是单样本的情况。 原始 RNN 块: (1)单步计算 H,包含两个矩阵向量乘法,和一个激活,复杂度HidSize² (2)一共有SeqLen步,所以整体复杂度SeqLen * HidSize² LSTM 块: (1)单步计算 F I C_hat O,包含八个矩阵向 ......

挑战Transformer的新架构Mamba解析以及Pytorch复现

今天我们来详细研究这篇论文“Mamba:具有选择性状态空间的线性时间序列建模” Mamba一直在人工智能界掀起波澜,被吹捧为Transformer的潜在竞争对手。到底是什么让Mamba在拥挤的序列建中脱颖而出? 在介绍之前先简要回顾一下现有的模型 Transformer:以其注意力机制而闻名,其中序 ......

《Span-Based Joint Entity and Relation Extraction with Transformer Pre-Training》阅读笔记

代码 原文地址 预备知识: 1.什么是束搜索算法(beam search)? beam search是一种用于许多自然语言处理和语音识别模型的算法,作为最终决策层,用于在给定目标变量(如最大概率或下一个输出字符)的情况下选择最佳输出。 2.什么是条件随机场(Conditional Random Fi ......

Wireless Sensor Network,Wireless Power Transmitio 无线传感器网络 无线充电技术

Wireless Sensor Network,Wireless Power Transmitio 无线传感器网络 无线充电技术 什么是无线传感器? 无线传感器是一种可以收集感官信息并检测本地环境变化的设备。无线传感器的示例包括接近传感器、运动传感器、温度传感器和液体传感器。无线传感器不会在本地执行 ......

软件定义网络(Software Defined Network, SDN )

软件定义网络(Software Defined Network, SDN ),是由美国斯坦福大学clean slate研究组提出的一种新型网络创新架构,其核心技术OpenFlow通过将网络设备控制面与数据面分离开来,从而实现了网络流量的灵活控制,为核心网络及应用的创新提供了良好的平台。 软件定义网络 ......

LLM增强LLM;通过预测上下文来提高文生图质量;Spikformer V2;同时执行刚性和非刚性编辑的通用图像编辑框架

文章首发于公众号:机器感知 LLM增强LLM;通过预测上下文来提高文生图质量;Spikformer V2;同时执行刚性和非刚性编辑的通用图像编辑框架 LLM Augmented LLMs: Expanding Capabilities through Composition 本文研究了如何高效地组合 ......

ICLR 2022: Anomaly Transformer论文阅读笔记+代码复现

本论文全名为Anomaly Transformer: Time Series Anomaly Detection with Association Descrepancy(通过关联差异进行时序异常检测),主要提出了一种无监督的异常点检测算法,并在6个benchmarks上测试,获取良好结果。 论文链 ......

概率霍夫变换(Progressive Probabilistic Hough Transform)原理详解

概率霍夫变换(Progressive Probabilistic Hough Transform)的原理很简单,如下所述: 1.随机获取边缘图像上的前景点,映射到极坐标系画曲线; 2.当极坐标系里面有交点达到最小投票数,将该点对应x-y坐标系的直线L找出来; 3.搜索边缘图像上前景点,在直线L上的点 ......

5、flink任务中可以使用哪些转换算子(Transformation)

5、flink任务中可以使用哪些转换算子(Transformation) <div id="content_views" class="htmledit_views"> <h1>1、什么是Flink中的转换算子</h1> 在使用 Flink DataStream API 开发流式计算任务时,可以将一 ......

Visual Transformer 与归纳偏置

开端 ViT(Visual Transformer)是 2020 年 Google 团队提出的将 Transformer 应用在图像分类的模型,但是当训练数据集不够大的时候,ViT 的表现通常比同等大小的 ResNets 要差一些。 为什么呢?寻找答案的过程中,发现了 归纳偏置 这个概念。 在阅读 ......

transformers 系列

Attention 注意力机制【1】-入门篇 注意力机制【2】- CV中的注意力机制 注意力机制【3】-Self Attention 注意力机制【4】-多头注意力机制 注意力机制【5】Scaled Dot-Product Attention 和 mask attention 注意力机制【6】-tra ......

Pandas - apply、agg、transform 函数

apply:行或列的操作。 agg:聚合,可以传递字典,对多个列使用不同的函数。最终结果可能会合并,与原 DataFrame 列长度不保持一致。 transform:转换,也可以对多个列使用不同的函数。但是最终结果与原 DataFrame 列长度保持一致,不会聚合。 ......

Swin Transformer

Swin Transformer 目录Swin Transformer简介VIT的缺陷核心创新总体结构和运作网络细节Patch partitionLinear EmbeddingPatch MergingSwin Block模块W-MSASW-MSAAttention Mask计算成本分析主要优势S ......

VIT Vision Transformer

VIT Vision Transformer 目录VIT Vision TransformerViT模型结构图像划分PatchLinear Projection of Flatted PatchesPatch+Position Embedding分类向量和位置向量EncoderMLP Head(全连 ......

DETR基于Transformer目标检测

DETR基于Transformer目标检测 目录DETR基于Transformer目标检测DETR网络结构和NLP Transformer对比Object QueryFFN为什么DETR不需要NMS优缺点参考资料 DETR首次将Transformer应用到了目标检测任务中。图像会先经过一个传统的CN ......

MMGCN: Multi-modal Graph Convolution Network for Personalized Recommendation of Micro-video

目录概符号说明MMGCN代码 Wei Y., Wang X., Nie L., He X., Hong R. and Chua T. MMGCN: Multi-modal graph convolution network for personalized recommendation of mic ......

CentOS Stream 8 Unit network.service not found

CentOS Stream 8 Unit network.service not found 一、问题现象 在 CentOS Stream 8 操作系统中,配置完静态IP 信息,想重启网络服务。 执行如下命令: systemctl restart network 提示信息如下: Failed to ......

Generalised f-Mean Aggregation for Graph Neural Networks

目录概符号说明GenAgg代码 Kortvelesy R., Morad S. and Prorok A. Generalised f-mean aggregation for graph neural networks. NIPS, 2023. 概 基于 MPNN 架构的 GNN 主要在于 agg ......

【Transformer 基础系列】手推显存占用

https://zhuanlan.zhihu.com/p/648924115 本文试图以最清晰的方式手动推导 Transformers 每一步的参数量到显存、计算量问题。理解底层,才能更好的做训练和优化。可能是目前最全的大模型显存优化方案分析。 本文内容包括(1)模型训练和推理过程中的显存占用(2) ......

Unity3D 通过transform实现人物移动还是velocity详解

Unity3D是一款非常流行的游戏引擎,它提供了多种方式来实现游戏中的人物移动。其中,最常用的两种方法是通过transform组件和通过velocity属性来实现。 对啦!这里有个游戏开发交流小组里面聚集了一帮热爱学习游戏的零基础小白,也有一些正在从事游戏开发的技术大佬,欢迎你来交流学习。 通过tr ......

kettle从入门到精通 第二十六课 再谈 kettle Transformation executor

1、前面文章有学习过Transformation executor ,但后来测试kettle性能的时候遇到了很大的问题,此步骤的处理性能太慢,导致内存溢出等问题。所以再次一起学习下此步骤的用法。 2、 如下图中rds-sametable-同步逻辑处理使用的是Transformation execut ......

Graph Condensation for Graph Neural Networks

目录概符号说明MotivationGCOND代码 Jin W., Zhao L., Zhang S., Liu Y., Tang J. and Shah N. Graph condensation for graph neural networks. ICLR, 2022. 概 图上做压缩的工作. ......