transformers handwriting论文

GPT-4竟成Nature审稿人?斯坦福清华校友近5000篇论文实测,超50%结果和人类评审一致

前言 斯坦福学者发现,GPT-4对于Nature、ICLR的论文给出的审稿意见,竟然和人类审稿人有超过50%的相似性。看来让大模型来帮我们审论文,并不是天方夜谭啊。 本文转载自新智元 仅用于学术分享,若侵权请联系删除 欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读 ......

Transformer

import math import torch from torch import nn import matplotlib.pyplot as plt from d2l import torch as d2l def sequence_mask(X, valid_len, value=0): " ......

论文阅读汇总

devnet \[dev(x)=\frac{\phi(x;\Theta) - \mu_\mathcal{R}}{\sigma_\mathcal{R}}\\ L(\phi(x;\Theta),\mu_\mathcal{R},\sigma_\mathcal{R})=(1-y)|dev(x)|+y\max ......

Implicit Autoencoder for Point-Cloud Self-Supervised Representation Learning论文阅读

2023 ICCV Implicit Autoencoder for Point-Cloud Self-Supervised Representation Learning论文阅读,思想很妙,该笔记非常简要 ......

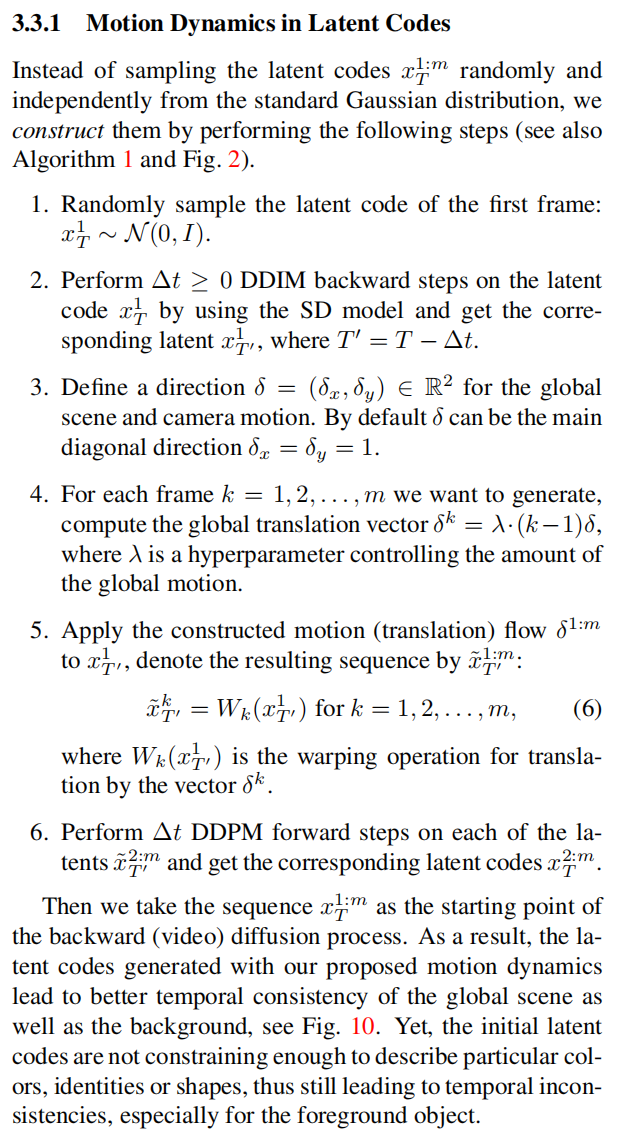

论文阅读(二)—— Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video Generators

——Adding Conditional Control to Text-to-Image Diffusion Models

= max( ......

Rethinking Point Cloud Registration as Masking and Reconstruction论文阅读

Rethinking Point Cloud Registration as Masking and Reconstruction论文阅读,用MAE的结构,想要预测出对齐后点云,然后提高跨点云间配准点的特征描述一致性。 ......

GNNExplainer: Generating Explanations for Graph Neural Networks论文阅读笔记

GNNExplainer: Generating Explanations for Graph Neural Networks论文阅读笔记 摘要 因为结合图结构和特征信息会导致复杂的模型,解释GNN的预测没有得到解决,所有提出了一个GNNExplainer,是第一个通用的,与模型无关的方法,可以 ......

[论文阅读] ECOD: Unsupervised Outlier Detection Using Empirical Cumulative Distribution Functions

ECOD: Unsupervised Outlier Detection Using Empirical Cumulative Distribution Functions Author:Zheng Li, Yue Zhao, Student Member Xiyang Hu, Nicola Bot ......

论文阅读:A Lightweight Knowledge Graph Embedding Framework for Efficient Inference and Storage

ABSTRACT 现存的KGE方法无法适用于大规模的图(由于存储和推理效率的限制) 作者提出了一种LightKG框架: 自动的推断出码本codebooks和码字codewords,为每个实体生成合适的embedding。 同时,框架中包含残差模块来实现码本的多样性,并且包含连续函数来近似的实现码字的 ......

transformer如何实现并行

RNN 无法并行 我们先看一个典型的基于RNN的Encoder-Decoder结构 输入是:“机器学习“,输出是“machine learning”。模型的大概工作时序是:Encoder部分,输入序列逐个送进RNN,计算出最后时刻的隐藏状态c,作为上下文信息传给Decoder。Decoder部分,将 ......

Informer: 一个基于Transformer的效率优化的长时间序列预测模型

Informer: 一个基于Transformer的效率优化的长时间序列预测模型 Informer创新点介绍 ProbSparse self-attention self-attention蒸馏机制 一步Decoder 实验结果 总结 Informer: Beyond Efficient Trans ......

记录第一次写论文的经历

记录第一次写论文的经历 2023年9月末,我投出了人生中的第一篇论文至某EI会议,领域是医学图像分割 刚开始写论文,很多细节的地方都不清楚,在此记录下我从中学会的一些与论文内容无关的东西,例如排版,用什么软件写等等 写论文用的软件 第一种是Word,这个是最常用的,有的时候比如毕业论文,可能要求必须 ......

如何降低视觉Transformer计算成本?时间冗余方法让人大吃一惊

前言 在为语言领域带来变革之后,Transformer 正在进军视觉领域,但其也有着高计算成本的问题。近日,威斯康星大学麦迪逊分校一个研究团队提出了 Eventful Transformer,可通过在视觉 Transformer 中利用时间冗余来节省成本。 本文转载自机器之心 仅用于学术分享,若侵权 ......

from_rnn_2_transformer-cnblog

从RNN到Transformer 各式各样的“attention” 不管是在CV领域还是NLP领域, attention实质上就是一种取权重求和的过程。使得网络focus在其应该focus的地方。 根据Attention的计算区域,可以分成以下几种: 1)Soft Attention,这是比较常见的 ......

Transformer 优缺点分析

https://aistudio.baidu.com/projectdetail/4909750 https://zhuanlan.zhihu.com/p/330483336 Transformer优点有位置关联操作不受限,建模能力强,通用性强,可扩展性强,能更好的进行并行运算。 Transform ......

【NIPS2021】Twins: Revisiting the Design of Spatial Attention in Vision Transformers

来自美团技术团队♪(^∀^●)ノシ 论文地址:https://arxiv.org/abs/2104.13840 代码地址:https://git.io/Twins 一、写在前面 本文提出了两种视觉转换器架构,即Twins-PCPVT和Twins-SVT。 Twins-PCPVT 将金字塔 Trans ......

如何通过毕业论文评审?

最近焦虑如何写好一篇毕业论文,拿出两位学长的毕业论文进行一番对比,得出一个有趣的结论。 首先介绍下两位学长的基本信息。 A学长:开发能力中等,文字描述能力较差,论文工作量大,一次通过; B学长:开发能力优秀,文字描述能力不错,论文工作量相对较少,二审。 结论:毕业论文有毕业论文的特点,对于系统设计类 ......

论文阅读:iterator zero-shot llm prompting for knowledge graph construction

Abstract 知识图谱,一种相互连接和可解释的结构。 生成需要更多的人力、领域知识、并需要适用于不同的应用领域。 本论文提出借助LLM,通过0-shot和外部知识不可知的情况下生成知识图谱。 主要贡献: 迭代的prompting提取最终图的相关部分 0-shot,不需要examples 一个可扩 ......

减少中文论文中的口语化表达

本文摘自: 论文口语化怎么改进? - 知乎 (zhihu.com) 论文口语化严重怎么修改? - 知乎 (zhihu.com) 一些研究者希望通过某种方式将如国家数据转换为某种形式的二维伪图片...... Du等人首次将卷积神经网络的思想引入......,文章/该研究将人体骨架节点坐标表示为图像,. ......

word论文写作参考

以zotero的插件插入参考文献 上交参考文献格式(跟哈工大格式相同) https://github.com/redleafnew/Chinese-STD-GB-T-7714-related-csl 批量修改语言,注意zotero版本 https://github.com/redleafnew/de ......

矩阵的乘法运算与css的3d变换(transform)

theme: qklhk-chocolate 引言:你有没好奇过,在一个使用了transform变换的元素上使用window.getComputedStyle(htmlElement)['transform'] 查询出来的值代表什么? 为什么硬件加速要使用transform,以及为什么硬件加速会快? ......

Density-invariant Features for Distant Point Cloud Registration论文阅读

Density-invariant Features for Distant Point Cloud Registration 2023 ICCV *Quan Liu, Hongzi Zhu, Yunsong Zhou, Hongyang Li, Shan Chang, Minyi Guo*; Pr ......

【论文2】自编码器为何Work?

在研究style latent space的概念时,我得到了对自编码器为何Work的解释: 因为模型需要重建压缩数据,所以它必须学会存储所有相关信息并忽略噪声。 这就是数据压缩的价值——它允许我们摆脱任何无关的信息,只关注最重要的特征。 ......