convolutional segmentation rethinking attention

Segment Anything笔记

title: Segment Anything笔记 banner_img: https://drive.studyinglover.com/api/raw/?path=/photos/blog/background/1679396994125.png date: 2023-4-7 21:40:00 ......

Convolutional Neural Networks on Graphs with Chebyshev Approximation, Revisited

目录概符号说明MotivationChebNetII代码 He M., Wei Z. and Wen J. Convolutional neural networks on graphs with chebyshev approximation, revisited. NIPS, 2022. 概 作 ......

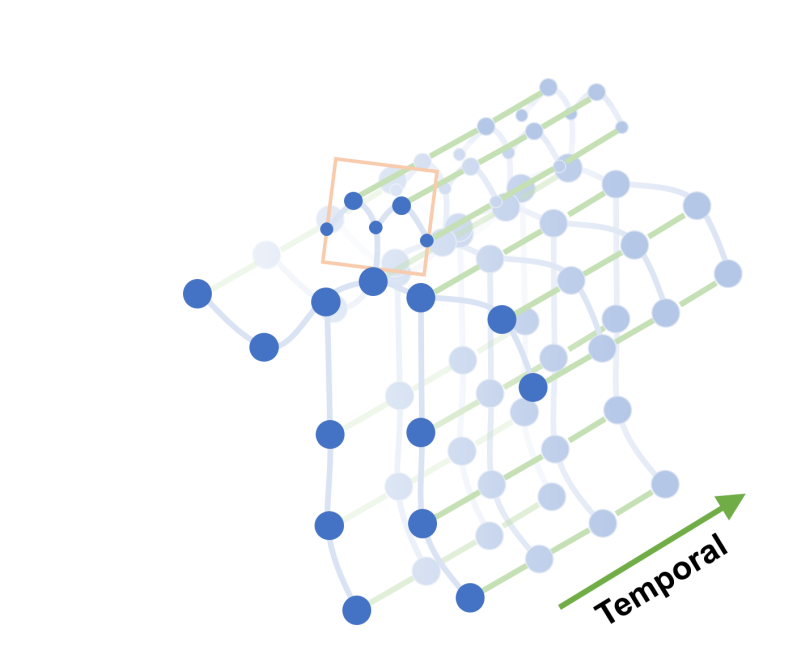

【略读论文|时序知识图谱补全】DREAM: Adaptive Reinforcement Learning based on Attention Mechanism for Temporal Knowledge Graph Reasoning

会议:SIGIR,时间:2023,学校:苏州大学计算机科学与技术学院,澳大利亚昆士兰布里斯班大学信息技术与电气工程学院,Griffith大学金海岸信息通信技术学院 摘要: 原因:现在的时序知识图谱推理方法无法生成显式推理路径,缺乏可解释性。 方法迁移:由于强化学习 (RL) 用于传统知识图谱上的多跳 ......

How Attentive are Graph Attention Networks?

目录概符号说明GATv2代码 Brody S., Alon U. and Yahav E. How attentive are graph attention networks? ICLR, 2022. 概 作者发现了 GAT 的 attention 并不能够抓住边的重要性, 于是提出了 GATv2 ......

《A Survey on Deep Learning-based Fine-grained Object Classification and Semantic Segmentation》阅读笔记

论文标题 《A Survey on Deep Learning-based Fine-grained Object Classification and Semantic Segmentation》 基于深度学习的细粒度对象分类和语义分割的综述 为什么是 “Object” 而不是 “image” 作 ......

MS-TCN++: Multi-Stage Temporal Convolutional Network for Action Segmentation

论文名: MS-TCN++: Multi-Stage Temporal Convolutional Network for Action Segmentation "MS-TCN++: 用于动作分割的多阶段时域卷积" Shi-Jie Li#, Yazan AbuFarha#, Yun Liu, Mi ......

[题解] CF1156E Special Segments of Permutation

Special Segments of Permutation 给你一个排列 \(p\),求有多少个区间 \([l, r]\) 满足 \(p_l + p_r = \max_{i \in [l, r]} p_i\)。 \(n \le 2 \times 10^5\)。 按最大值分治,记当前的分治中心为 ......

RLHF · PBRL | SURF:使用半监督学习,对 labeled segment pair 进行数据增强

① 将 high-confidence 的预测 (σ0, σ1) 标上 pseudo-label;② 将 labeled segment pair 进行时序剪裁,得到更多数据增强的 labeled pair。 ......

[题解] CF1327F AND Segments

AND Segments 有 \(m\) 个限制 \((l, r, x)\)。 要计算满足以下条件的长度为 \(n\) 的序列 \(a\) 的数量: \(\forall i \in [1, n], 0 \le a_i < 2^k\)。 \(\forall i \in [1, m], a_{l_i} ......

Self-Attention公式解释

Transformer的注意力机制被广泛应用于自然语言处理(NLP)领域中,它主要用于解决序列到序列的模型中长距离依赖问题。 长距离依赖问题 举个例子,考虑这个句子: “The cat, which was very hungry, finally found its food in the kit ......

[题解]CFgym103470E Paimon Segment Tree

Paimon Segment Tree 区间加,求一段时间内的区间平方和。 \(n, m, q \le 5 \times 10^4\)。 对时间维差分一下,变成询问区间历史平方和。 离线下来扫描线,扫描线维护时间维,数据结构维护序列维。 考虑维护二元组 \((a, s)\) 表示当前位置值为 \(a ......

Distilling Knowledge from Graph Convolutional Networks

目录概符号说明DistillGCNLocal Structure Preserving代码 Yang Y., Qiu J., Song M., Tao D. and Wang X. Distilling knowledge from graph convolutional networks. CVP ......

《Generic Dynamic Graph Convolutional Network for traffic flow forecasting》阅读笔记

论文标题 《Generic Dynamic Graph Convolutional Network for traffic flow forecasting》 干什么活:交通流预测(traffic flow forecasting ) 方法:动态图卷积网络(Dynamic Graph Convolu ......

解码注意力Attention机制:从技术解析到PyTorch实战

在本文中,我们深入探讨了注意力机制的理论基础和实际应用。从其历史发展和基础定义,到具体的数学模型,再到其在自然语言处理和计算机视觉等多个人工智能子领域的应用实例,本文为您提供了一个全面且深入的视角。通过Python和PyTorch代码示例,我们还展示了如何实现这一先进的机制。 关注TechLead, ......

聊聊RNN与Attention

RNN系列: 聊聊RNN&LSTM 聊聊RNN与seq2seq attention mechanism,称为注意力机制。基于Attention机制,seq2seq可以像我们人类一样,将“注意力”集中在必要的信息上。 Attention的结构 seq2seq存在的问题 seq2seq中使用编码器对时序 ......

深度学习之Attention Model(注意力模型)

https://www.cnblogs.com/jiangxinyang/p/9367497.html 1、Attention Model 概述 深度学习里的Attention model其实模拟的是人脑的注意力模型,举个例子来说,当我们观赏一幅画时,虽然我们可以看到整幅画的全貌,但是在我们深入仔细 ......

比Transformer更好,无Attention、MLPs的BERT、GPT反而更强了

前言 本文探索了 Monarch Mixer (M2) ,这是一种在序列长度和模型维度上都是次二次的新架构,并且在现代加速器上具有很高的硬件效率。 本文转载自机器之心 仅用于学术分享,若侵权请联系删除 欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。 ......

E. Tracking Segments

E. Tracking Segments 题目大意: 给一个全为零的数组,m次询问区间,q次修改,定义一个区间中的1个数严格大于0个数为漂亮,问在第几次修改后出现了第一个完美区间。 思路: 对修改次数进行二分,利用前缀和判断区间中的1个数,时间复杂度为$mlog(q)$ code int n, m; ......

《Attention Is All You Need》阅读笔记

论文标题 《Attention Is All You Need》 XXX Is All You Need 已经成一个梗了,现在出现了很多叫 XXX Is All You Need 的文章,简直标题党啊,也不写方法,也不写结果,有点理解老师扣论文题目了。 作者 这个作者栏太夸张了。八个作者全部标星,均 ......

PAT_A1104 Sum of Number Segments

Given a sequence of positive numbers, a segment is defined to be a consecutive subsequence. For example, given the sequence { 0.1, 0.2, 0.3, 0.4 }, we ......

CF1572F Stations 题解-Segment Tree Beats

20231025 CF1572F Stations 题解-Segment Tree Beats 吉司机线段树好题!!!CF3400。 传送门 Statement 有 \(n\) 个广播站,第 \(i\) 个广播站高度为 \(h_i\),范围为 \(w_i\)。初始 \(h_i=0,w_i=i\)。广 ......

论文:Going Deeper with Convolutions-GoogleNet

论文名: Going Deeper with Convolutions 深入了解卷积 了解GoogleNet 研究问题: 研究方法: 主要结论: 模型: 问题: 行文结构梳理: ......

CF981E Addition on Segments

将操作按右端点从小到大排序,这样对于当前值相同的点,只有最右边的那一个是有用的。 令 \(f_i\) 表示当前值为 \(i\) 最靠右的点的位置,转移直接暴力判断能否取 \(\max\) 即可,时间复杂度 \(O(nq)\)。 这个东西看起来就不好优化。 不妨调换状态和值,令 \(f_{i,j}\) ......

FlashAttention 如何加速Attention计算?

代数聚合 计算向量\(\mathbf x^l \in \mathbb R^{1 \times d}\)的softmax值 \[m(\mathbf x^l) = max(x_i^{l}) \\ f(\mathbf x^l) = [e^{x_1^l-m(\mathbf x^l)}, \cdots, e^ ......

CF837G Functions On The Segments

CF837G Functions On The Segments Functions On The Segments - 洛谷 | 计算机科学教育新生态 (luogu.com.cn) 目录CF837G Functions On The Segments题目大意思路code 题目大意 你有 \(n\) ......

【Python&语义分割】Segment Anything(SAM)模型交互式分割+掩膜保存(三)

我之前分享了Segment Anything(SAM)模型的基本操作,这篇给大家分享下交互式语义分割代码,可以通过鼠标点击目标物生成对应的掩膜,同时我还加入了掩膜保存的代码。 ......

论文阅读(四)—— Spatial Temporal Graph Convolutional Networks for Skeleton-Based Action Recognition

![image](https://img2023.cnblogs.com/blog/3279428/2... ......

Attention Is All You Need

Attention Is All You Need 关键词:Self-Attention、Transformer 📜 研究主题 设计仅基于注意力机制的网络Transformer Transformer仍然采用Encoder-Decoder结构,但脱离了Seq2Seq结构,不采用RNN或CNN单元 ......

论文:Very deep convolutional networks for large-scale image recognition-VGG

论文名: Very deep convolutional networks for large-scale image recognition "用于大规模图像识别的深度卷积网络" 了解VGG模型 研究问题: 研究方法: 主要结论: 模型: 问题: 行文结构梳理: ......