Training

《Span-Based Joint Entity and Relation Extraction with Transformer Pre-Training》阅读笔记

代码 原文地址 预备知识: 1.什么是束搜索算法(beam search)? beam search是一种用于许多自然语言处理和语音识别模型的算法,作为最终决策层,用于在给定目标变量(如最大概率或下一个输出字符)的情况下选择最佳输出。 2.什么是条件随机场(Conditional Random Fi ......

C. Training Before the Olympiad

原题链接 题解 事实1.两个数合并后的数一定是偶数 事实2.如果没有发生奇数和偶数合并,那么最终的结果一定是所有数的和 事实3.每发生一次奇数和偶数合并,最后的结果会减一 总结 综上所述,Masha会尽量选择同奇或同偶合并,但在有同奇的情况下,会优先选择同奇,因为合并会产生偶数,且Olya需要用到奇 ......

CF1916C Training Before the Olympiad

思路 首先,我们可以考虑两个人会怎么操作,如果是选择了两个偶数和两个奇数,那么答案不会减小,如果选择了一个奇数一个偶数,那么答案会减小一。 所以想使答案大的人应该尽量选择前一种方案,想使答案小的人应该尽量选择后一种方案。 但这还不是最优的,想使答案大的人在可以选择两个奇数时,绝对不会选择两个偶数,因 ......

InstructGPT《InstructGPT: Training language models to follow instructions with human feedback》解读

背景 GPT-3 虽然在各大 NLP 任务以及文本生成的能力上令人惊艳,但是他仍然还是会生成一些带有偏见的,不真实的,有害的造成负面社会影响的信息,而且很多时候,他并不按人类喜欢的表达方式去说话。在这个背景下,OpenAI 提出了一个概念“Alignment”,意思是模型输出与人类真实意图对齐,符合 ......

GPT-1论文《Improving Language Understanding by Generative Pre-Training》解读

背景 GPT-1 采用了两阶段训练的方式: 1. 第一阶段 pre-training,在海量文本上训练,无需label,根据前k-1个词预测第k个单词是什么,第一阶段的训练让模型拥有了很多的先验知识,模型具有非常强的泛化性 2. 第二阶段在特定任务上fine-tuning,让模型能适应不同的任务,提 ......

【论文阅读笔记】【多模态-Vision-Language Pretraining】 BLIP: Bootstrapping Language-Image Pre-training for Unified Vision-Language Understanding and Generation

BLIP ICML 2022 (Spotlight) 读论文思考的问题 论文试图解决什么问题?写作背景是什么? 问题: 在视觉-语言预训练(VLP)中,如何更加高效地利用充斥着噪声的海量图文对数据,提升预训练效果? 如何设计模型,使得预训练后的模型在理解(understanding-based)任务 ......

A fast and simple algorithm for training neural probabilistic language models

目录概Noise contrastive estimation Mnih A. and Teh Y. W. A fast and simple algorithm for training neural probabilistic language models. ICML, 2012. 概 NCE ......

【论文阅读笔记】【多模态-Referring & Grounding】 Grounded Language-Image Pre-training

GLIP CVPR 2022 (Oral, Best Paper Finalist) 读论文思考的问题 论文试图解决什么问题?写作背景是什么? 问题: 如何将视觉-语言预训练技术应用在以目标检测为代表的 fine-grained image understanding 上面? 如何在增加训练数据的同 ......

GLIP:Grounded Language-Image Pre-training

Grounded Language-Image Pre-training 目录Grounded Language-Image Pre-training简介摘要Introduction统一的损失函数方法总结参考资料 GLIPv1: Grounded Language-Image Pre-trainin ......

Misc_XCTF_WriteUp | Training-Stegano-1

题目 提示:这是我能想到的最基础的图片隐写术 题目: 分析 文件属性没有特别的东西。 这么小的图片用 StegSolve 也看不见啥,用 010 editor 打开看看: 有一段文本,大意是:“看看十六进制编辑显示了什么:passwd:steganoI” 将 steganoI 作为 flag 提交, ......

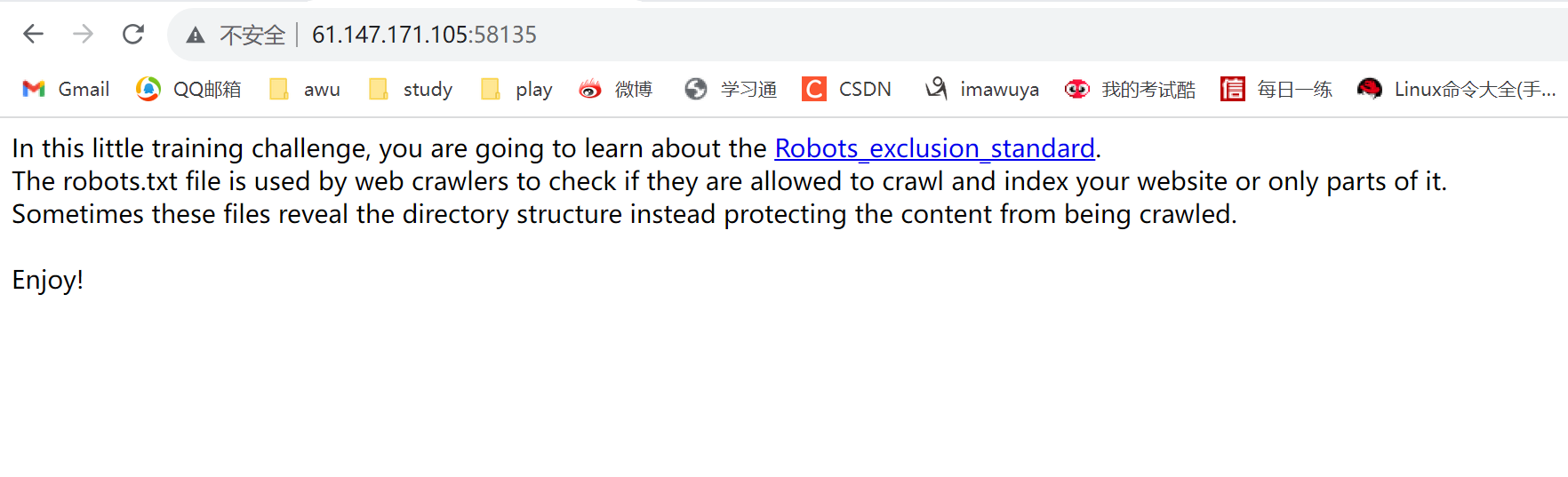

Web_XCTF_WriteUp | Training-WWW-Robots

题目 分析 标题大致翻译: 训练 WWW 网络爬虫。 场景内部文段大致翻译: 在这个小小的训练挑战中,您将学习 Robots_exclusion_standard(网络爬虫排除标准)。 robots.txt 文件用于网络爬虫检查它们是否被允许抓取和索引您的网站或仅部分网站。 有时,这些文件揭示了目录 ......

【论文阅读】Improving language understanding by generative pre-training

原始题目:Improving language understanding by generative pre-training 中文翻译:通过生成预训练提高语言理解能力 发表时间:2018年 平台:Preprint 文章链接:https://www.mikecaptain.com/resource ......

[ARC123E] Training

多测,求值 \[\sum_{i=1}^{n}\Big[a+\lfloor\frac{i}{b}\rfloor=c+\lfloor\frac{i}{d}\rfloor\Big] \]\(1\le T\le 2\times 10^5\),\(1\le n\le 10^9\),\(1\le a,b,c,d ......

基于时间频率一致性对时间序列进行自监督对比预训练《Self-Supervised Contrastive Pre-Training for Time Series via Time-Frequency Consistency》(时序、时频一致性、对比学习)

2023年11月10日,今天看一篇论文,现在17:34,说实话,想摆烂休息,不想看,可还是要看,拴Q。 论文:Self-Supervised Contrastive Pre-Training for Time Series via Time-Frequency Consistency 或者是:Sel ......

【找到 Anchor-based and Anchor-free 性能差距的本质】Adaptive Training Sample Selection (ATSS) 论文精读

原始题目:Bridging the Gap Between Anchor-based and Anchor-free Detection via Adaptive Training Sample Selection 中文翻译:通过 自适应训练样本选择 缩小 Anchor-based and Anch ......

GraphPrompt: Unifying Pre-Training and Downstream Tasks for Graph Neural Networks

目录概符号说明GraphPrompt代码 Liu Z., Yu X., Fang Y. and Zhang X. GraphPrompt: Unifying pre-training and downstream tasks for graph neural networks. WWW, 2023. ......

GPT-GNN: Generative Pre-Training of Graph Neural Networks

目录概符号说明GPT-GNN代码 Hu Z., Dong Y., Wang K., Chang K. and Sun Y. GPT-GNN: Generative pre-training of graph neural networks. KDD, 2020. 概 比较早的一篇图预训练模型. 符号 ......

Training language models to follow instructions with human feedback

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布! NeurIPS 2022 ......

Proj CDeepFuzz Paper Reading: SparseProp: Efficient Sparse Backpropagation for Faster Training of Neural Networks

## Abstract 本文:SparseProp Github: https://github.com/IST-DASLab/sparseprop Task: a back-propagation algo for sparse training data, a fast vectorized i ......

论文解读(CST)《Cycle Self-Training for Domain Adaptation》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Cycle Self-Training for Domain Adaptation论文作者:Hong Liu, Jianmin Wang, Mingsheng Long论文来源:2021 论文地址:down ......

论文解读(MTEM)《Meta-Tsallis-Entropy Minimization: A New Self-Training Approach for Domain Adaptation on Text Classification》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Meta-Tsallis-Entropy Minimization: A New Self-Training Approach for Domain Adaptation on Text Classific ......

Training Your Own LoRAs

https://tfwol.github.io/text-generation-webui/Training-LoRAs.html#format-files text-generation-webui Training Your Own LoRAs The WebUI seeks to make t ......

精进语言模型:探索LLM Training微调与奖励模型技术的新途径

# 精进语言模型:探索LLM Training微调与奖励模型技术的新途径 LLMs Trainer 是一个旨在帮助人们从零开始训练大模型的仓库,该仓库最早参考自 [Open-Llama](https://github.com/beichao1314/Open-Llama),并在其基础上进行扩充。 有 ......

论文解读(TAT)《 Transferable Adversarial Training: A General Approach to Adapting Deep Classifiers》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Transferable Adversarial Training: A General Approach to Adapting Deep Classifiers论文作者:Hong Liu, Mingsh ......

UESTC 2023 Summer Training #23 for div2/2022-2023 ACM-ICPC Latin American Regional Programming Contest

# Preface 今天这场签到巨多,和昨天那场形成了鲜明的对比 但可惜后盘的时候我划了太久的水,最后接了B题然后没调出来成为战俘 最气的是赛后发现原来是没注意输出格式,本来可以说一遍过的题结果没写过,属实可惜,就当长教训了 **以后一定要尤其注意输入输出格式** # A. Asking for M ......

training acc比test acc小的情况

今天跑实验遇到了training acc比test acc小的情况,查找了一些资料之后发现有以下一些可能: 1. 使用了dropout,在训练的时候使用了dropout, 但是在test的时候其实没有dropout了。 2. learning rate太大了,(我就属于这个情况) 3. 数据集太小了 ......

【攻防世界】-Training-WWW-Robots

# 信息收集  翻译: 在这个小小的训练挑战中,你将学习机器人的排除标准。robots.txt文件用于网络 ......

A Novel Noise Injection-based Training Scheme for Better Model Robustness

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布! https://arxiv.org/abs/2302.10802 ......

UESTC 2023 Summer Training #13 Div.2

# Preface 开始裸泳咯这个A题给我写的头皮发麻,后面发现我就是个智障儿童 比赛的时候E题想了半天感觉天皇老子来了也是$\frac{1}{n^2}$,赛后发现我是小丑 感觉中间做J的时候因为看错题目浪费了很长时间,不过再给一个小时思博题该不会还是不会 # A. Paint the Middle ......