transformer quality linear论文

SHARPNESS-AWARE MINIMIZATION FOR EFFICIENTLY IMPROVING GENERALIZATION论文阅读笔记

Intro 在训练集上最小化损失很可能导致泛化性低,因为当今模型的过参数化会导致training loss的landscape异常复杂且非凸,包含很多local/global minima,因此优化器的选择至关重要。loss landscape的几何性质(特别是minima的flatness)与泛化 ......

CF1506D - Epic Transformation

思路 用优先队列模拟 ac代码 #include <bits/stdc++.h> using namespace std; using i64 = long long; const i64 inf = 8e18; typedef pair<int, int> pii; const int N = 5 ......

LLM series: Transformer

🥥 Homepage Dataset, DataLoader, and Transforms Model Traning Model 🥑 Get Started! Import libraries: import torch import torch.nn as nn import torch. ......

美国财团是如何控制美国教育界的 —— 哈佛史上最短任期!53岁女校长宣布辞职,博士论文被指抄袭

相关: 哈佛史上最短任期!53岁女校长宣布辞职,博士论文被指抄袭 ......

[论文阅读] Self-conditioned Image Generation via Generating Representations

Pre title: Self-conditioned Image Generation via Generating Representations accepted: arXiv 2023 paper: https://arxiv.org/abs/2312.03701 code: https:/ ......

Learning Dynamic Query Combinations for Transformer-based Object** Detection and Segmentation论文阅读笔记

Motivation & Intro 基于DETR的目标检测范式(语义分割的Maskformer也与之相似)通常会用到一系列固定的query,这些query是图像中目标对象位置和语义的全局先验。如果能够根据图像的语义信息调整query,就可以捕捉特定场景中物体位置和类别的分布。例如,当高级语义显示图 ......

[NLP复习笔记] Transformer

1. Transformer 概述 1.1 整体结构 \(\text{Transformer}\) 主要由 \(\text{Encoder}\) 和 \(\text{Decoder}\) 两个部分组成。\(\text{Encoder}\) 部分有 \(N = 6\) 个相同的层,每层包含 一个 \( ......

1211. Queries Quality and Percentage

这道题目不难,但是有很多需要考虑的点以及容易写错的地方。 SELECT query_name, ROUND(AVG(rating/position), 2) AS quality, ROUND(SUM(CASE WHEN rating < 3 THEN 1 ELSE 0 END) * 100 / C ......

gurobipy: Gurobi Optimizer is a mathematical optimization software library for solving mixed-integer linear and quadratic optimization problems

Project description The Gurobi Optimizer is a mathematical optimization software library for solving mixed-integer linear and quadratic optimization p ......

论文写作方法

公式居中编号靠右 https://www.bilibili.com/video/BV1Xd4y1Z7Xi/?spm_id_from=333.337.search-card.all.click&vd_source=f0c0211a242fdec2b56aa48b9d63c70e 公式编辑器:matht ......

RNN 和 Transformer 复杂度比较

这里假设BatchSize为 1,就是单样本的情况。 原始 RNN 块: (1)单步计算 H,包含两个矩阵向量乘法,和一个激活,复杂度HidSize² (2)一共有SeqLen步,所以整体复杂度SeqLen * HidSize² LSTM 块: (1)单步计算 F I C_hat O,包含八个矩阵向 ......

挑战Transformer的新架构Mamba解析以及Pytorch复现

今天我们来详细研究这篇论文“Mamba:具有选择性状态空间的线性时间序列建模” Mamba一直在人工智能界掀起波澜,被吹捧为Transformer的潜在竞争对手。到底是什么让Mamba在拥挤的序列建中脱颖而出? 在介绍之前先简要回顾一下现有的模型 Transformer:以其注意力机制而闻名,其中序 ......

【略读论文|大模型相关】Zero-Shot Relational Learning on Temporal Knowledge Graphs with Large Language Models

时间:2023 学校:慕尼黑大学 创新点: 1.据我们所知,这是第一个试图在TKGF背景下研究零射击关系学习的工作。 2.我们设计了一种基于llm的方法zrLLM,并设法在零射击关系推理中增强各种基于嵌入的TKGF模型。 3.实验结果表明,zrLLM有助于大大提高所有考虑的TKGF模型对包含未见零射 ......

《Span-Based Joint Entity and Relation Extraction with Transformer Pre-Training》阅读笔记

代码 原文地址 预备知识: 1.什么是束搜索算法(beam search)? beam search是一种用于许多自然语言处理和语音识别模型的算法,作为最终决策层,用于在给定目标变量(如最大概率或下一个输出字符)的情况下选择最佳输出。 2.什么是条件随机场(Conditional Random Fi ......

机器学习周刊 第4期:动手实战人工智能、计算机科学热门论文、免费的基于ChatGPT API的安卓端语音助手、每日数学、检索增强 (RAG) 生成技术综述

LLM开发者必读论文:检索增强(RAG)生成技术综述! 目录: 1、动手实战人工智能 Hands-on Al 2、huggingface的NLP、深度强化学习、语音课 3、Awesome Jupyter 4、计算机科学热门论文 5、LLM开发者必读论文:检索增强 (RAG) 生成技术综述 6、App ......

机器学习周刊03:如何学习深度学习?2024 年学习生成式 AI 路线图、如何构建高效的RAG系统、苹果 腾讯最新论文、阿里DreaMoving

腾讯推出的 AppAgent,是一个多模态智能体,通过识别当前手机的界面和用户指令直接操作手机界面,能像真实用户一样操作手机! 机器学习周刊:关注Python、机器学习、深度学习、大模型等硬核技术 1、如何学习深度学习? 最近X上有推友重提这篇文章,是网友看过 Jeremy 教授的 fast.ai ......

ICLR 2022: Anomaly Transformer论文阅读笔记+代码复现

本论文全名为Anomaly Transformer: Time Series Anomaly Detection with Association Descrepancy(通过关联差异进行时序异常检测),主要提出了一种无监督的异常点检测算法,并在6个benchmarks上测试,获取良好结果。 论文链 ......

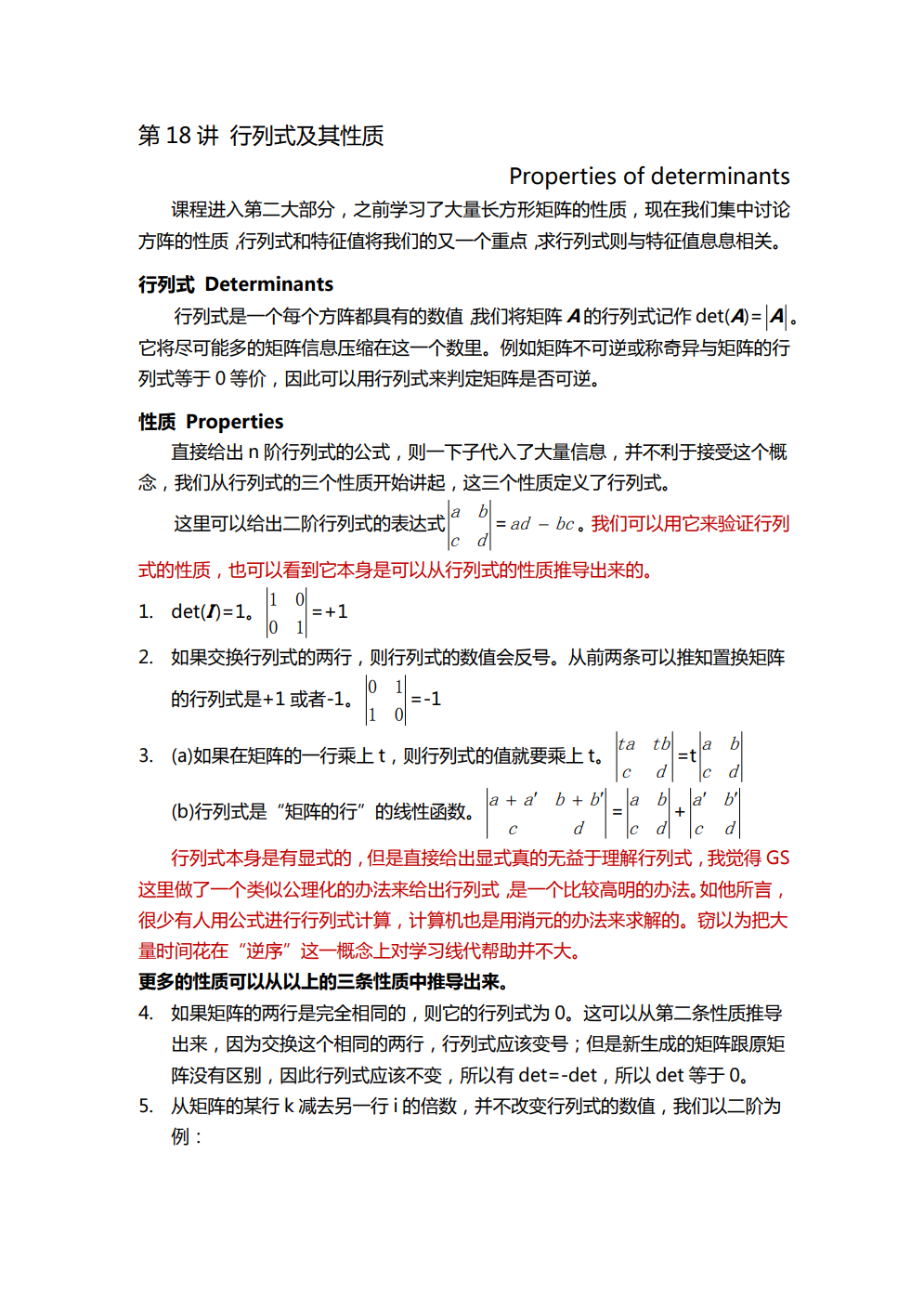

MIT18.06Linear Algebra 第18讲 行列式及其性质

神经信息处理系统大会是当前全球最负盛名的 AI 学术会议之一,将于 12 月 10 日在美国新奥尔良召开。官方信息显示,本届会议共有 12343 篇有效论文投稿,接收率为 26.1%,略高于 ......

概率霍夫变换(Progressive Probabilistic Hough Transform)原理详解

概率霍夫变换(Progressive Probabilistic Hough Transform)的原理很简单,如下所述: 1.随机获取边缘图像上的前景点,映射到极坐标系画曲线; 2.当极坐标系里面有交点达到最小投票数,将该点对应x-y坐标系的直线L找出来; 3.搜索边缘图像上前景点,在直线L上的点 ......

5、flink任务中可以使用哪些转换算子(Transformation)

5、flink任务中可以使用哪些转换算子(Transformation) <div id="content_views" class="htmledit_views"> <h1>1、什么是Flink中的转换算子</h1> 在使用 Flink DataStream API 开发流式计算任务时,可以将一 ......

ChatGPT论文降重Prompt

你是一个已经阅读过大量论文的论文写作专家。我正在设计一个基于xxx系统。接下来,我将给你一个论文段落,你可以使用调整句子用词、句子结构等方法,重新描述这段话,对文章的内容进行润色,使之更加接近论文的写作风格。你也可以自己增添一些描述和内容。 ......

大模型评测-微软亚洲研究院:A Survey on Evaluation of Large Language Models论文分享

《A Survey on Evaluation of Large Language Models》 一、论文介绍:微软亚洲研究院公开了介绍大模型评测领域的论文《A Survey on Evaluation of Large Language Models》。该论文一共调研了219篇文献,以评测内容 ......

论文精读—多智能体算法在无人机集群的运用

导:“在阅读一篇论文后,要对这几个方面有清晰的认识,动机、创新点和实验设计,外加自己对这篇论文有什么想法” 论文解读:本文组织如下:第二节介绍了相关工作,第三节介绍了大规模搜索场景和系统模型,第四节详细介绍了基于marl的无人机群搜索方法,第五节讨论了仿真设置和实验结果,第六节总结了本文。 建模思考 ......

Visual Transformer 与归纳偏置

开端 ViT(Visual Transformer)是 2020 年 Google 团队提出的将 Transformer 应用在图像分类的模型,但是当训练数据集不够大的时候,ViT 的表现通常比同等大小的 ResNets 要差一些。 为什么呢?寻找答案的过程中,发现了 归纳偏置 这个概念。 在阅读 ......

AAAI 2024 | 腾讯优图实验室27篇论文入选,含表格结构识别、异常图像生成、医学图像分割等研究方向

前言 AAAI 2024 (AAAI Conference on Artificial Intelligence) 人工智能国际会议于近日公布论文录用结果,本届会议共收到9862篇份论文投稿,最终录用2342篇论文,录用率23.75%。AAAI 是美国人工智能协会主办的年会,同时也是是人工智能领域中 ......

transformers 系列

Attention 注意力机制【1】-入门篇 注意力机制【2】- CV中的注意力机制 注意力机制【3】-Self Attention 注意力机制【4】-多头注意力机制 注意力机制【5】Scaled Dot-Product Attention 和 mask attention 注意力机制【6】-tra ......