self-attention公式attention self

Attention Is All You Need

Attention Is All You Need * Authors: [[Ashish Vaswani]], [[Noam Shazeer]], [[Niki Parmar]], [[Jakob Uszkoreit]], [[Llion Jones]], [[Aidan N. Gomez]], ......

Expectation-Maximization Attention Networks for Semantic Segmentation 使用了EM算法的注意力

Expectation-Maximization Attention Networks for Semantic Segmentation * Authors: [[Xia Li]], [[Zhisheng Zhong]], [[Jianlong Wu]], [[Yibo Yang]], [[Zho ......

CBAM: Convolutional Block Attention Module

CBAM: Convolutional Block Attention Module * Authors: [[Sanghyun Woo]], [[Jongchan Park]], [[Joon-Young Lee]], [[In So Kweon]] doi:https://doi.org/10. ......

PSANet: Point-wise Spatial Attention Network for Scene Parsing双向注意力

PSANet: Point-wise Spatial Attention Network for Scene Parsing * Authors: [[Hengshuang Zhao]], [[Yi Zhang]], [[Shu Liu]], [[Jianping Shi]], [[Chen Cha ......

Object Tracking Network Based on Deformable Attention Mechanism

Object Tracking Network Based on Deformable Attention Mechanism Local library 初读印象 comment:: (DeTrack)采用基于可变形注意力机制的编码器模块和基于自注意力机制的编码器模块相结合的方式进行特征交互。基于 ......

BiFormer: Vision Transformer with Bi-Level Routing Attention 使用超标记的轻量ViT

alias: Zhu2023a tags: 超标记 注意力 rating: ⭐ share: false ptype: article BiFormer: Vision Transformer with Bi-Level Routing Attention * Authors: [[Lei Zhu] ......

A Deformable Attention Network for High-Resolution Remote Sensing Images Semantic Segmentation可变形注意力

A Deformable Attention Network for High-Resolution Remote Sensing Images Semantic Segmentation * Authors: [[Renxiang Zuo]], [[Guangyun Zhang]], [[Rong ......

GCGP:Global Context and Geometric Priors for Effective Non-Local Self-Attention加入了上下文信息和几何先验的注意力

Global Context and Geometric Priors for Effective Non-Local Self-Attention * Authors: [[Woo S]] 初读印象 comment:: (GCGP)提出了一个新的关系推理模块,它包含了一个上下文化的对角矩阵和二维相 ......

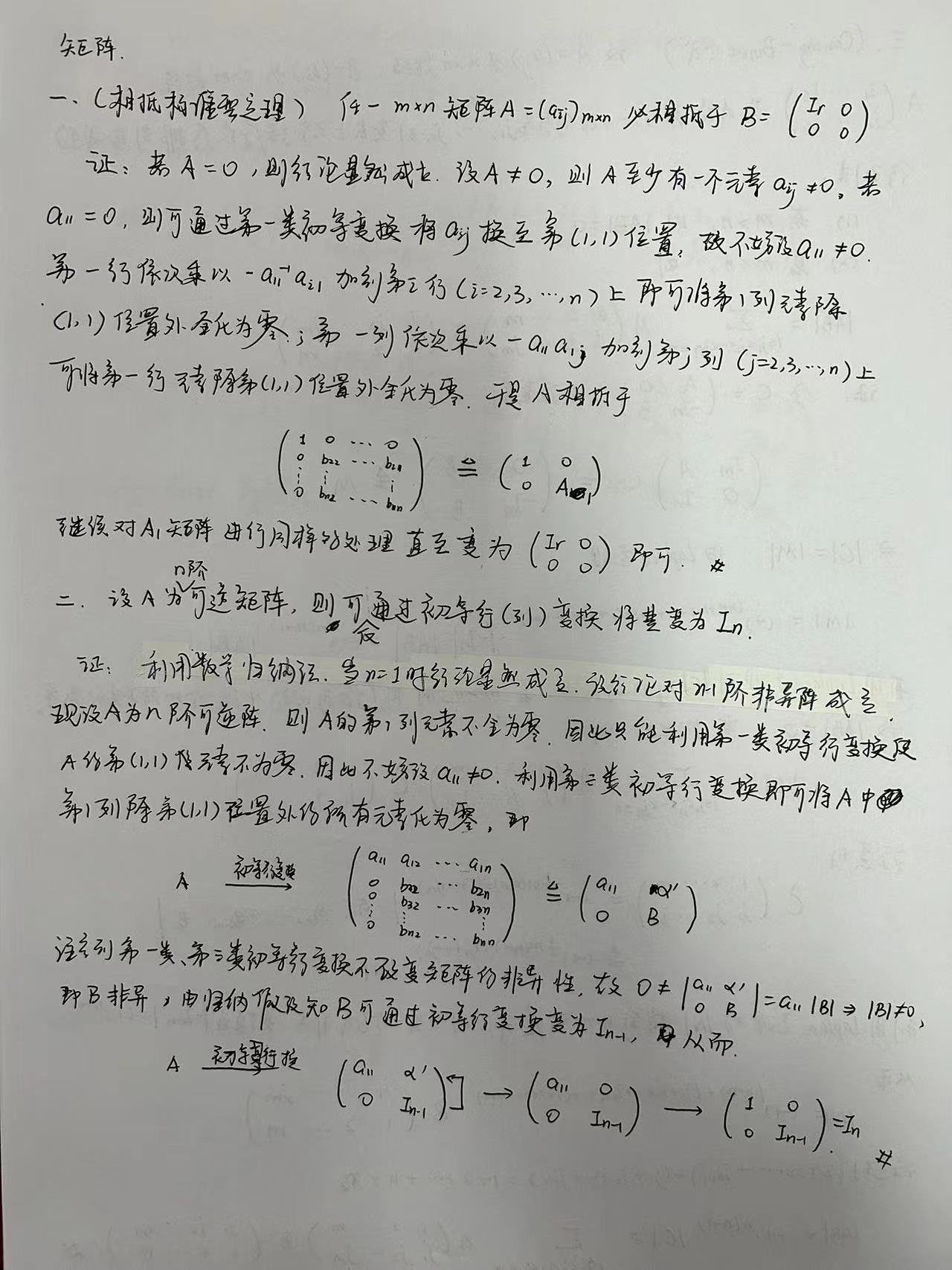

相抵标准型定理与Cauchy-Binet公式

= P(B|A) * P(A) / P(B) 其中: P(A|B) 是在事件B发生的条件下事件A发生的 ......

word公式显示不全,公式和文字错位问题

类似于这种情况: 1. 文字和公式错位; 2. 公式上抬导致显示不全; 解决方法: 1. 选中该段 2. 字体→高级→位置→标准 3. 段落→中文版式→文本对齐方式→自动 效果 : ......

Excel 公式SWITCH函数你用过吗?多种查找函数介绍

我们公司的项目上的模板使用了Excel的Switch函数,今天我使用的时候,发现报错,无法使用。 环境说明 我使用的是Windows 10 专业版,Office 2016 报错信息 在Excel中的报错如下: 单元格的公式如下: =F8*_xlfn.SWITCH(H8,"高",1.5,"中",1," ......

递归和master公式

递归的本质是系统帮我们进行了压栈,栈的名字叫做系统栈。但系统栈的空间十分有限,因此在工程上我们需要把递归改写成用内存中的栈来模拟系统压栈,以此来实现非递归。 master公式又叫主定理,是一种估算递归时间复杂度的公式。但有个前提条件:只有是子问题规模相同的递归才能使用。 T(N) = a * T(N ......

Flash-attention 2.3.2 支持 Windows了,但是我的2080ti是不支持的。

不久前Flash-attention 2.3.2 终于支持了 Windows,推荐直接使用大神编译好的whl安装 github.com/bdashore3/flash-attention/releasesstable diffusion webui flash-attention2性能测试 安装环境 ......

【论文解读】System 2 Attention提高大语言模型客观性和事实性

本文简要介绍了论文“System 2 Attention (is something you might need too) ”的相关工作。基于transformer的大语言模型(LLM)中的软注意很容易将上下文中的不相关信息合并到其潜在的表征中,这将对下一token的生成产生不利影响。为了帮助纠正... ......

The Devil Is in the Details: Window-based Attention for Image Compression

目录简介 简介 基于CNN的模型的一个主要缺点是 cNN结构不是为捕捉局部冗余而设计的,尤其是非重复纹理,这严重影响了重建质量。受视觉转换器(ViT)和Swin Transformer最新进展的启发,我们发现将局部感知注意机制与全局相关特征学习相结合可以满足图像压缩的期望。 介绍了一种更简单有效的基 ......

因果推断入门 21 调整公式adjustment formula

https://www.bilibili.com/video/BV1o541127wE/?p=21&spm_id_from=pageDriver 图1 当上一节定义了干涉之后,如何定义因果关系呢?图中X是treatment,Y是Outcome。 定义的办法就是假想给所有人吃药,然后看他们恢复的概率。 ......

论文笔记: Attributed Graph Clustering: A Deep Attentional Embedding Approach

论文笔记: Attributed Graph Clustering: A Deep Attentional Embedding Approach 中文名称: 属性图聚类:一种深度注意力嵌入方法 论文链接: https://arxiv.org/abs/1906.06532 背景: 图聚类是发现网络 ......

unity Transform 的 Rotate(xAngle: float, yAngle: float, zAngle: float, relativeTo: Space = Space.Self, Space.World); 刨根问底

public class demoword2 : MonoBehaviour { // Start is called before the first frame update void Start() { //transform.Rotate(60, 70, 80, Space.World); ......

Attention 2015-今

现在attention的热度已经过去了,基本上所有的attention都是transformer的kqv形式的,甚至只要说道attention,默认就是transformer的attention。 为避免遗忘历史,我这里做一个小总结。繁杂的att我就不去了解了,只了解下经典的。 以下以\(h_i\) ......

System 2 Attention:可以提高不同LLM问题的推理能力

推理正在成为大型语言模型(llm)关注的下一个主要领域。尽管llm拥有先进的能力,但大多数llm经常被简单的错误绊倒,显示出他们在推理方面的局限性。这些模型可能会被上下文中的不相关细节所误导,或者受到输入提示中的偏差的影响。而后一种倾向被称为谄媚,也就是说模型会更偏向与输入一致,而不管准确性如何。人 ......

Excel公式

Excel公式 cell内容比较 IF(A1=B1, "0", "1") 同效果:=A1=B1 =NOT(A1=B1)*1 时间型变换表示 dim a, b a="17: 1: 2" b=Format(a, "hh:mm:ss") ⇒17:01:02 b=Format(a, "hh時mm分ss秒") ......

公式识别任务各个链条全部打通

引言 随着LaTeX-OCR模型转换问题的解决,公式识别任务中各个链条已经全部打通。小伙伴们可以放开膀子干了。 解决业界问题的方案,并不是单独训练一个模型就完事了,而是有着上下游的依赖。这就像工厂中流水线作业一样,一个小东西的生产是依赖无数个中间阶段才完成的。 一个模型应用到产品中,也是有着类似的流 ......

Predicting gene expression from histone modifications with self-attention based neural networks and transfer learning

Predicting gene expression from histone modifications with self-attention based neural networks and transfer learning Yuchi Chen 1, Minzhu Xie 1, Jie ......

博客园插入公式的方法

第一:设置 -> 页首Html代码, 加入如下代码 <script src="http://latex.codecogs.com/latex.js" type="text/javascript"></script> 第二:选项 -> 将启用数学公式支持勾选 第三:打开在线LaTex公式编辑器 htt ......

Jupyter Notebook 数学公式

转载至: https://blog.csdn.net/smilejiasmile/article/details/80670742 https://www.zybuluo.com/codeep/note/163962 1.如何插入公式 行中公式(放在文中与其它文字混编)可以用如下方法表示:$ 数学公 ......

Word 怎么在公式的右侧加入编号

直接在公式末尾输入井号 #。然后加上编号,再敲一下回车,就可以快速将编号右对齐 引用:https://zhuanlan.zhihu.com/p/144052211 原始样式 最终效果 ......

C1. Good Subarrays (Easy Version)(推公式找性质)

思路: \[能想到平方是比较特殊的,因为x*x一定是x的倍数也就是说\sqrt[2]{x*x} = {x} \]\[所以需要考虑平法之间的数手模一下样例可以发现 [x^2 ,(x+1)^2)之间是x倍数的有x^2 \]\[x*(x+1), x*(x+2)这三个,所以可以知道平方之间有三个,只要讨论一 ......

[论文速览] Randomized Quantization@ A Generic Augmentation for Data Agnostic Self-supervised Learning

Pre title: Randomized Quantization: A Generic Augmentation for Data Agnostic Self-supervised Learning accepted: ICCV 2023 paper: https://arxiv.org/abs ......